在 LibreChat 中使用 ClickHouse MCP 服务器

本指南介绍如何使用 Docker 设置 LibreChat 与 ClickHouse MCP 服务器, 并将其连接到 ClickHouse 示例数据集。

安装 Docker

您需要 Docker 来运行 LibreChat 和 MCP 服务器。获取 Docker 的方法:

- 访问 docker.com

- 下载适用于您操作系统的 Docker Desktop

- 请根据您所使用的操作系统的说明安装 Docker

- 打开 Docker Desktop,并确保其正在运行。

有关更多信息,请参阅 Docker 文档。

创建并编辑 .env 文件

将示例配置文件从 .env.example 复制到 .env:

使用您喜欢的文本编辑器打开 .env 文件。您将看到许多流行的 LLM 提供商的配置部分,例如 OpenAI、Anthropic、AWS Bedrock 等:

将 user_provided 替换为您要使用的 LLM 提供商的 API 密钥。

如果您没有 API 密钥,可以使用像 Ollama 这样的本地 LLM。您将在后续的 "安装 Ollama" 步骤中了解如何操作。现在 请不要修改 .env 文件,继续执行后续步骤。

将 ClickHouse MCP 服务器添加到 Docker Compose

接下来,我们将把 ClickHouse MCP 服务器添加到 LibreChat 的 Docker Compose 文件中, 以便 LLM 能够与 ClickHouse SQL playground 交互。

创建一个名为 docker-compose.override.yml 的文件,并将以下配置添加到其中:

如果您想探索自己的数据,您可以使用自己 ClickHouse Cloud 服务的 主机地址、用户名和密码 进行连接。

在 librechat.yaml 中配置 MCP 服务器

打开 librechat.yaml 文件,并将以下配置添加到文件末尾:

这会使 LibreChat 连接到在 Docker 中运行的 MCP 服务器。

找到以下行:

为简化操作,我们暂时取消身份验证要求:

使用 Ollama 添加本地 LLM(可选)

安装 Ollama

前往 Ollama 网站 并为您的系统安装 Ollama。

安装完成后,您可以按如下方式运行模型:

如果本地尚未存在该模型,该命令会自动将其拉取到本机。

有关模型列表,请参阅 Ollama library

在 librechat.yaml 中配置 Ollama

模型下载完成后,在 librechat.yaml 中对其进行配置:

在浏览器中打开 LibreChat

所有服务启动并运行后,打开浏览器并访问 http://localhost:3080/

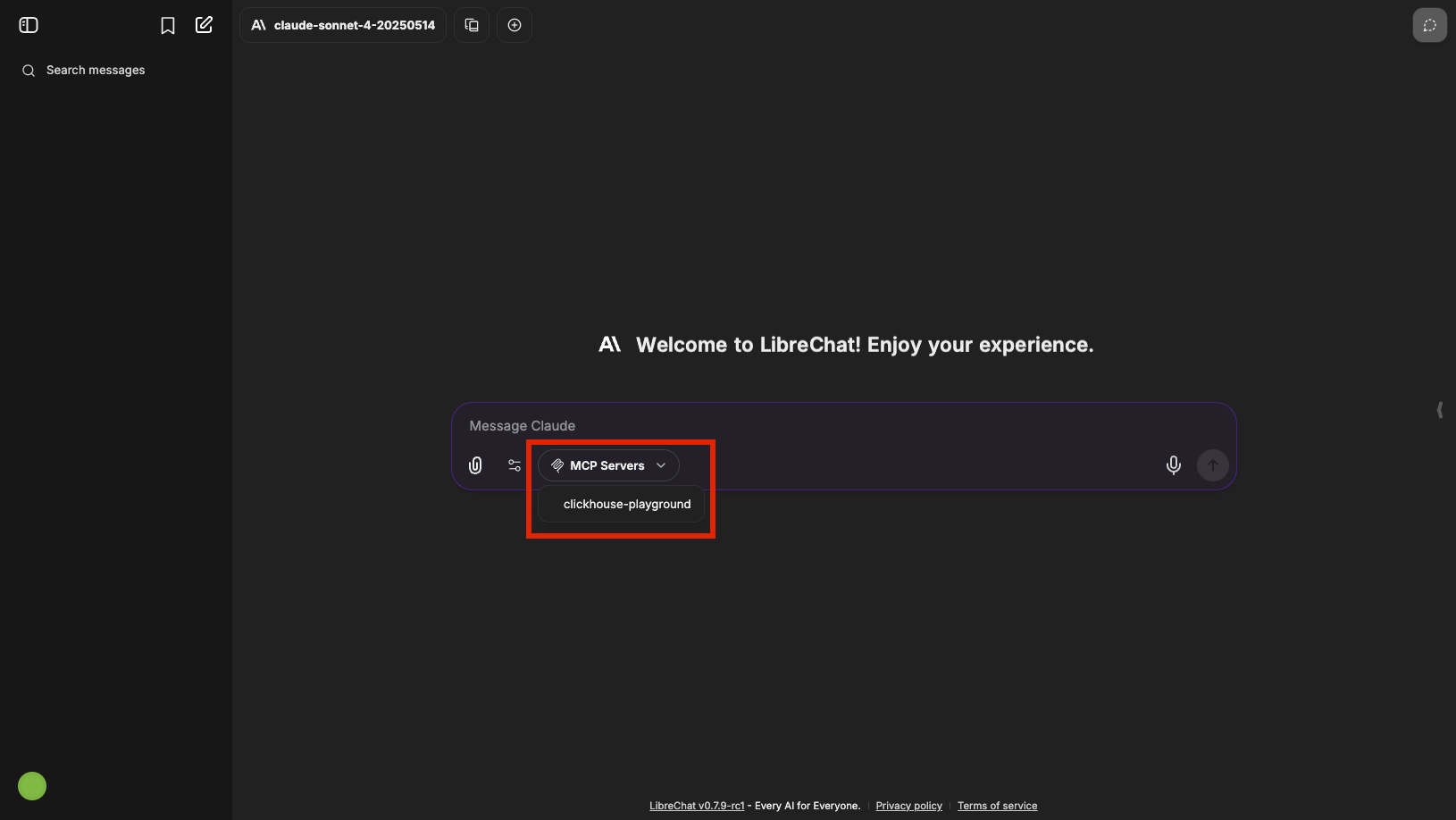

如果您还没有 LibreChat 账号,请创建一个免费账号并登录。现在您应该能看到 LibreChat 界面已连接到 ClickHouse MCP 服务器,以及(可选)您的本地 LLM。

在聊天界面中,选择 clickhouse-playground 作为您的 MCP 服务器:

现在您可以提示 LLM 探索 ClickHouse 示例数据集。试一试:

如果在 LibreChat UI 中没有看到 MCP 服务器选项,

请检查是否在 librechat.yaml 文件中正确配置了权限。

如果在 interface 下的 mcpServers 部分中将 use 设置为 false,则聊天界面中不会显示 MCP 服务器选择下拉框: