对象存储 ClickPipes 提供了一种简单且健壮的方式,用于将 Amazon S3、Google Cloud Storage、Azure Blob Storage 和 DigitalOcean Spaces 中的数据摄取到 ClickHouse Cloud。既支持一次性摄取,也支持持续摄取,并保证严格一次(exactly-once)语义。

创建第一个对象存储 ClickPipe

先决条件

- 您已阅读并熟悉 ClickPipes 简介。

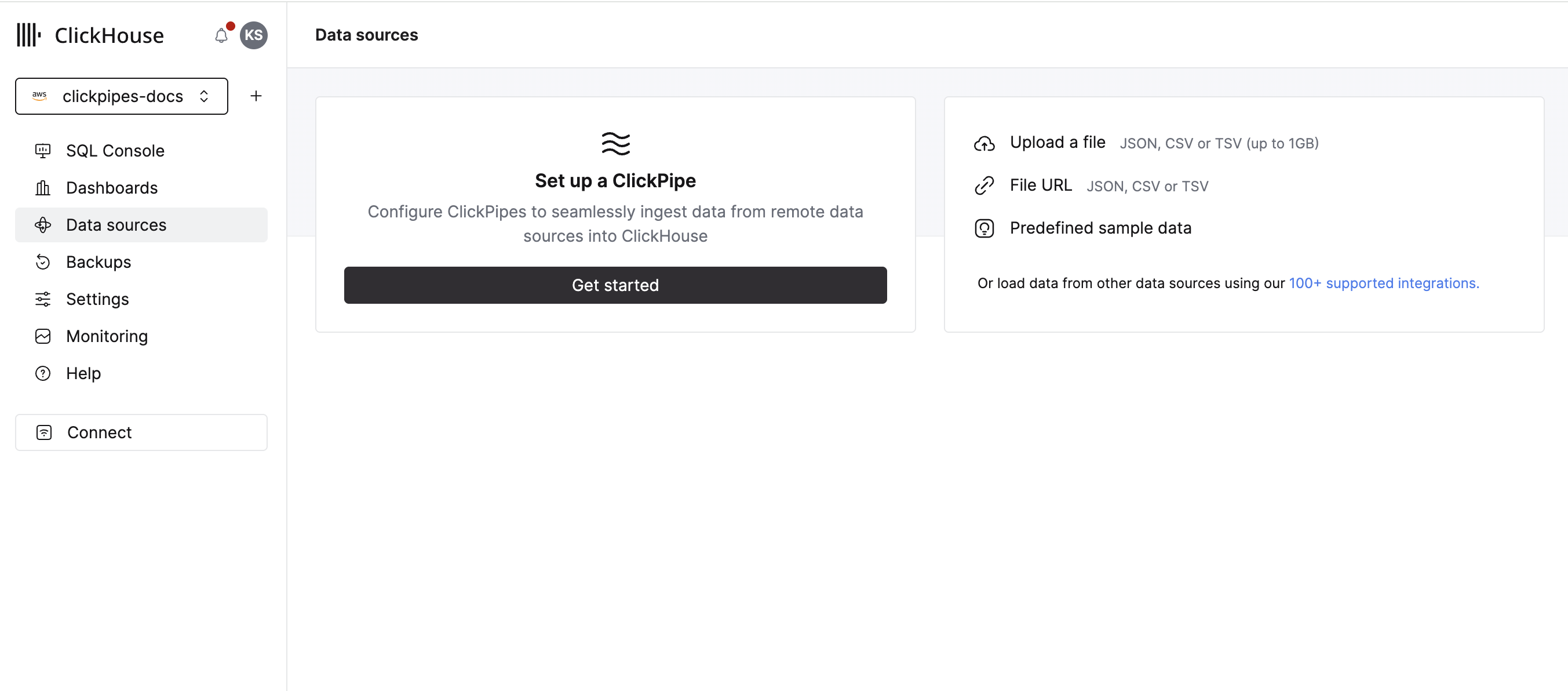

进入数据源

在云控制台左侧菜单中选择 Data Sources 按钮,然后点击“Set up a ClickPipe”

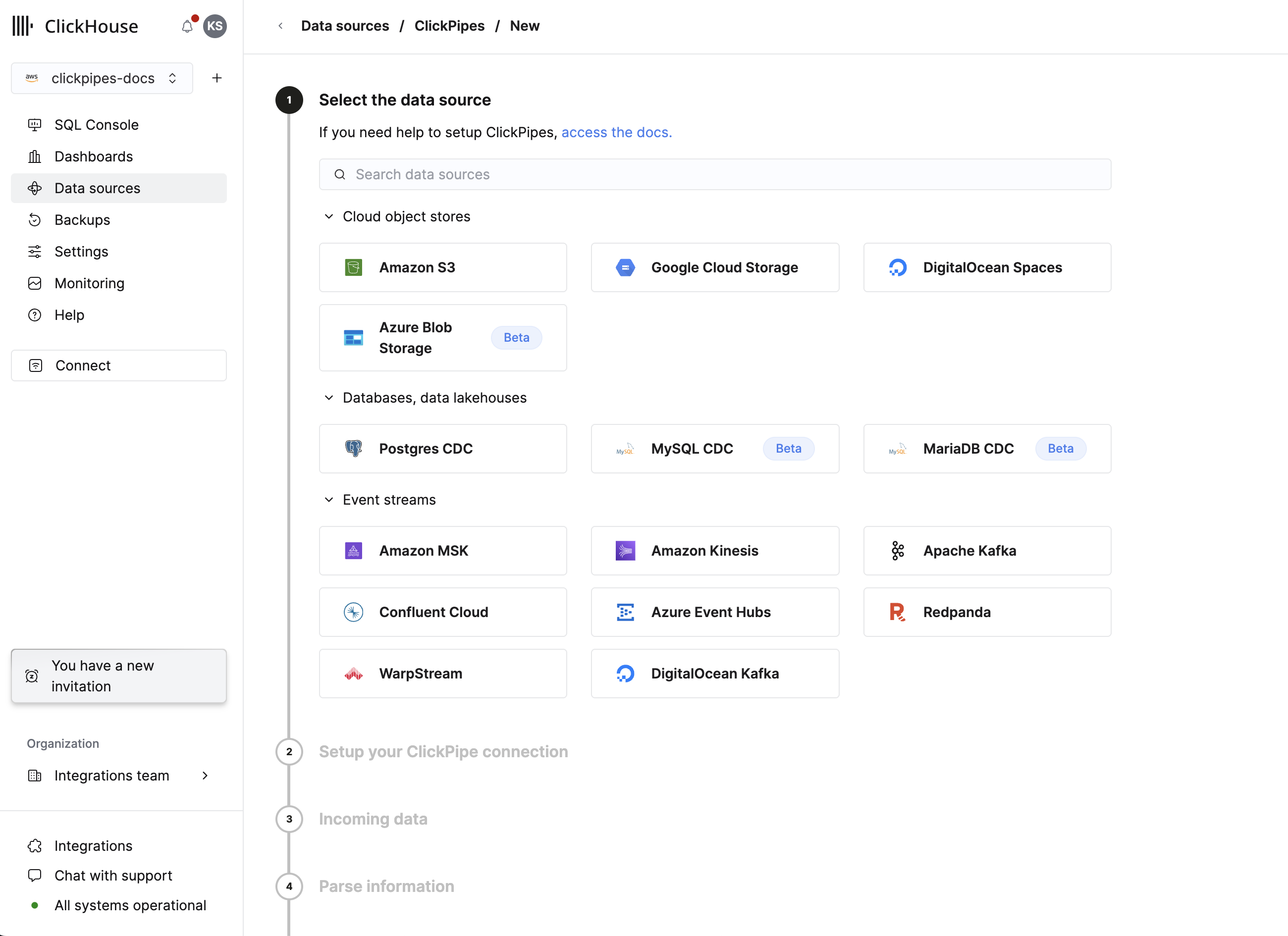

选择数据源

选择数据源。

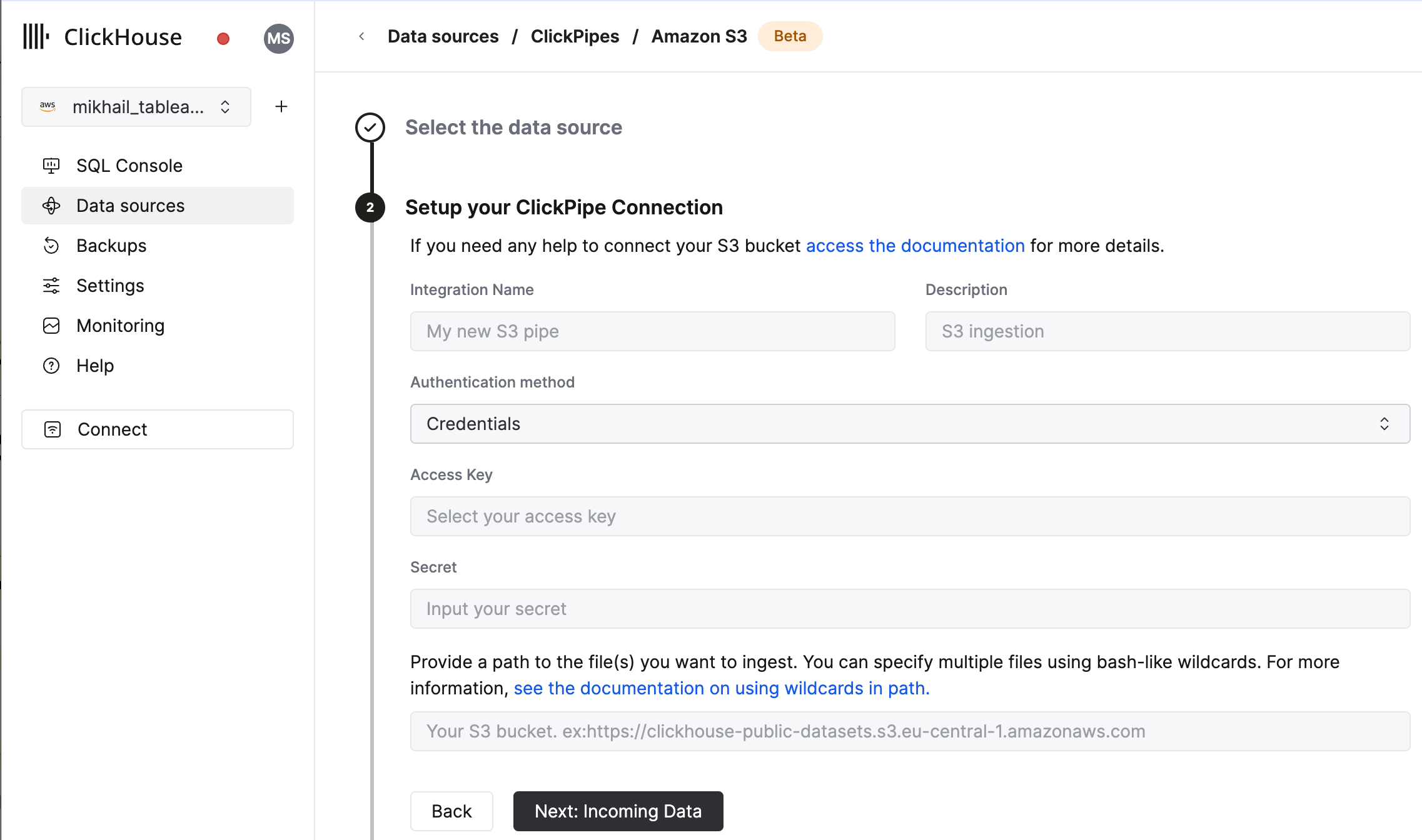

配置 ClickPipe

在表单中为 ClickPipe 填写名称、描述(可选)、IAM 角色或凭证以及存储桶(bucket)URL。 你可以使用类似 Bash 的通配符来指定多个文件。 有关更多信息,请参阅关于在路径中使用通配符的文档。

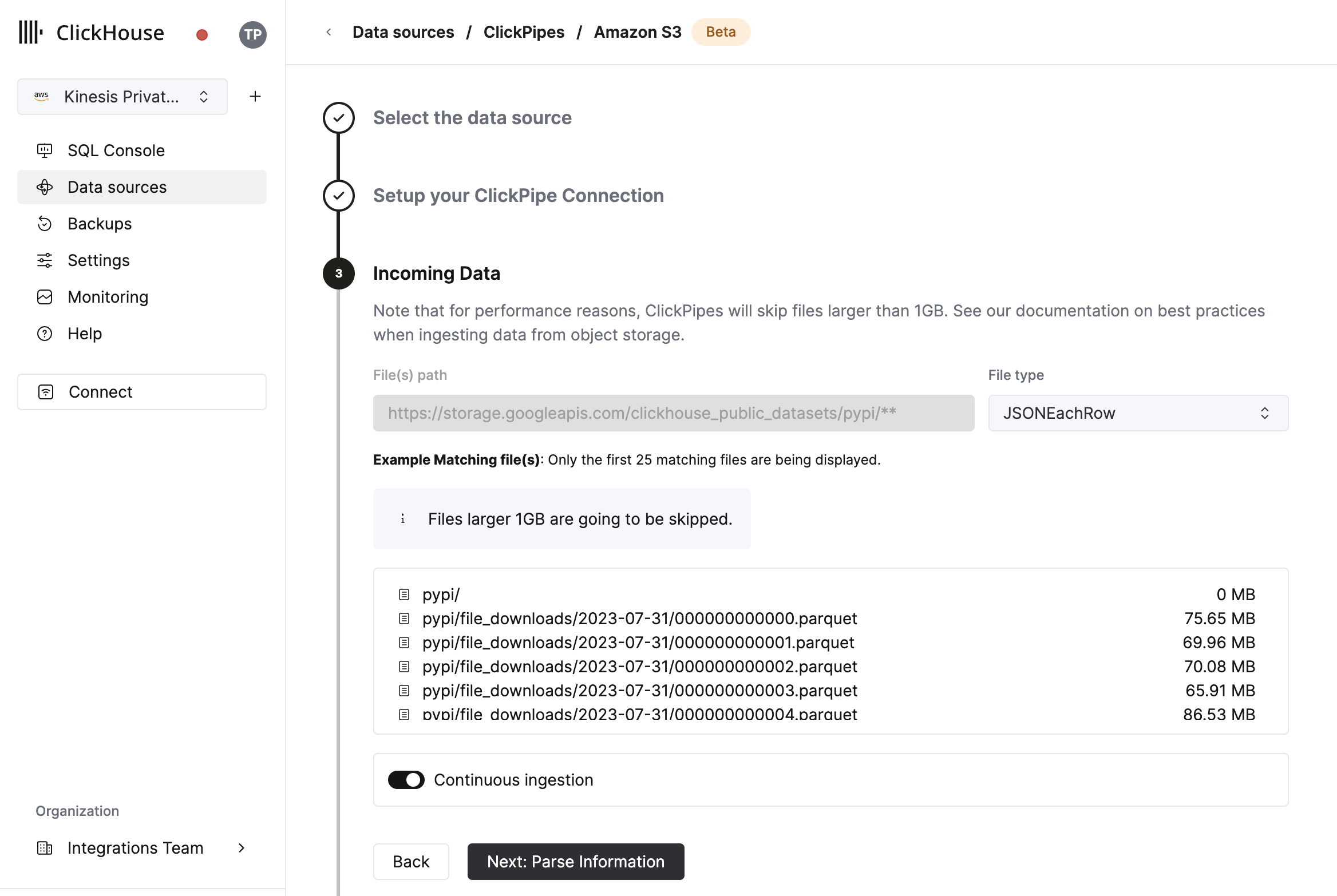

选择数据格式

UI 会显示指定 bucket 中的文件列表。 选择你的数据格式(当前支持部分 ClickHouse 格式),并选择是否要启用持续摄取。 (下面有更多细节)。

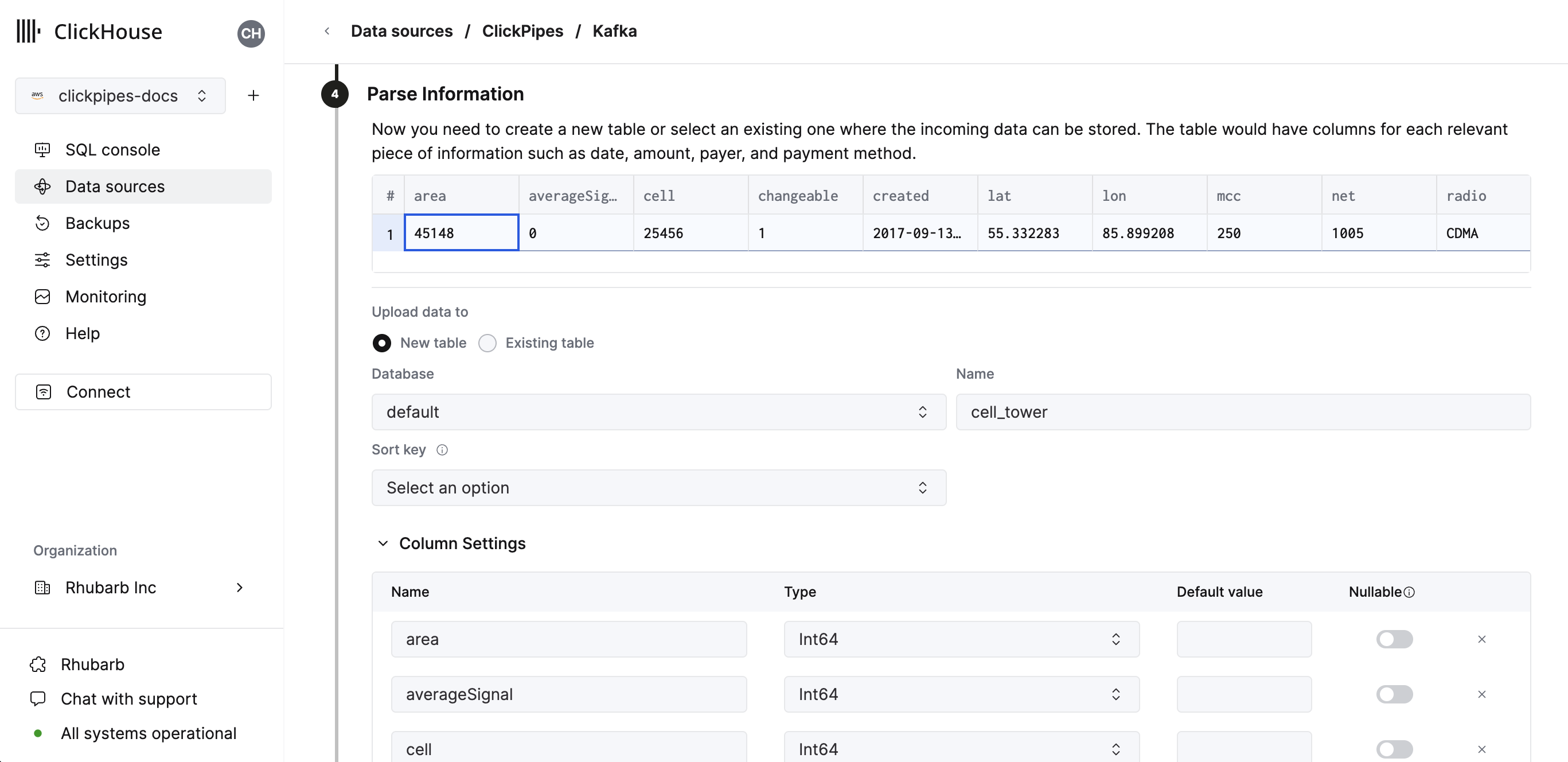

配置表、表结构和设置

在下一步中,你可以选择将数据摄取到一个新的 ClickHouse 表中,或者复用一个已有的表。 按照界面上的指引修改你的表名、表结构和设置。 你可以在顶部的示例表中实时预览你的更改。

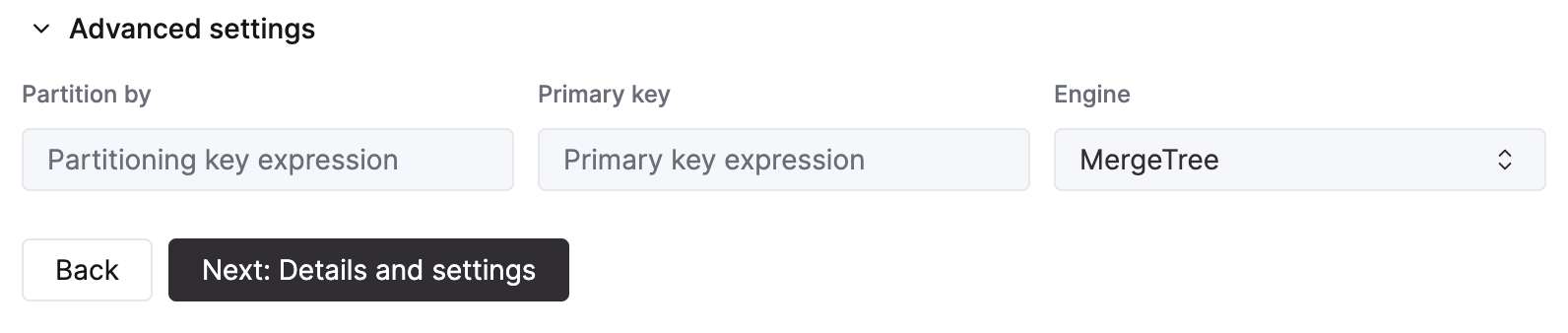

你也可以使用提供的控件自定义高级设置。

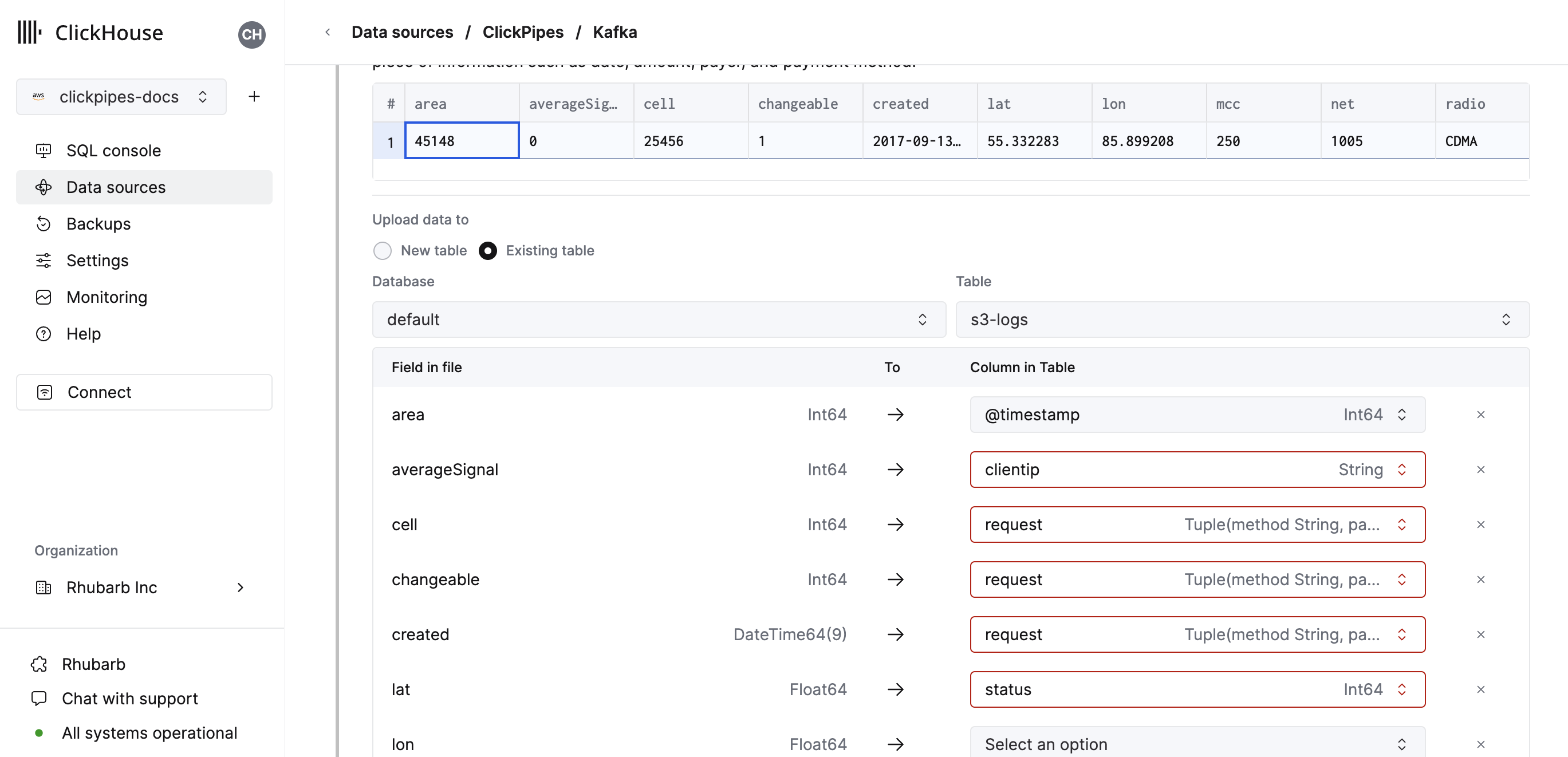

或者,你也可以选择将数据摄取到已有的 ClickHouse 表中。 在这种情况下,UI 允许你将源中的字段映射到所选目标表中的 ClickHouse 字段。

你也可以将虚拟列(例如 _path 或 _size)映射到字段上。

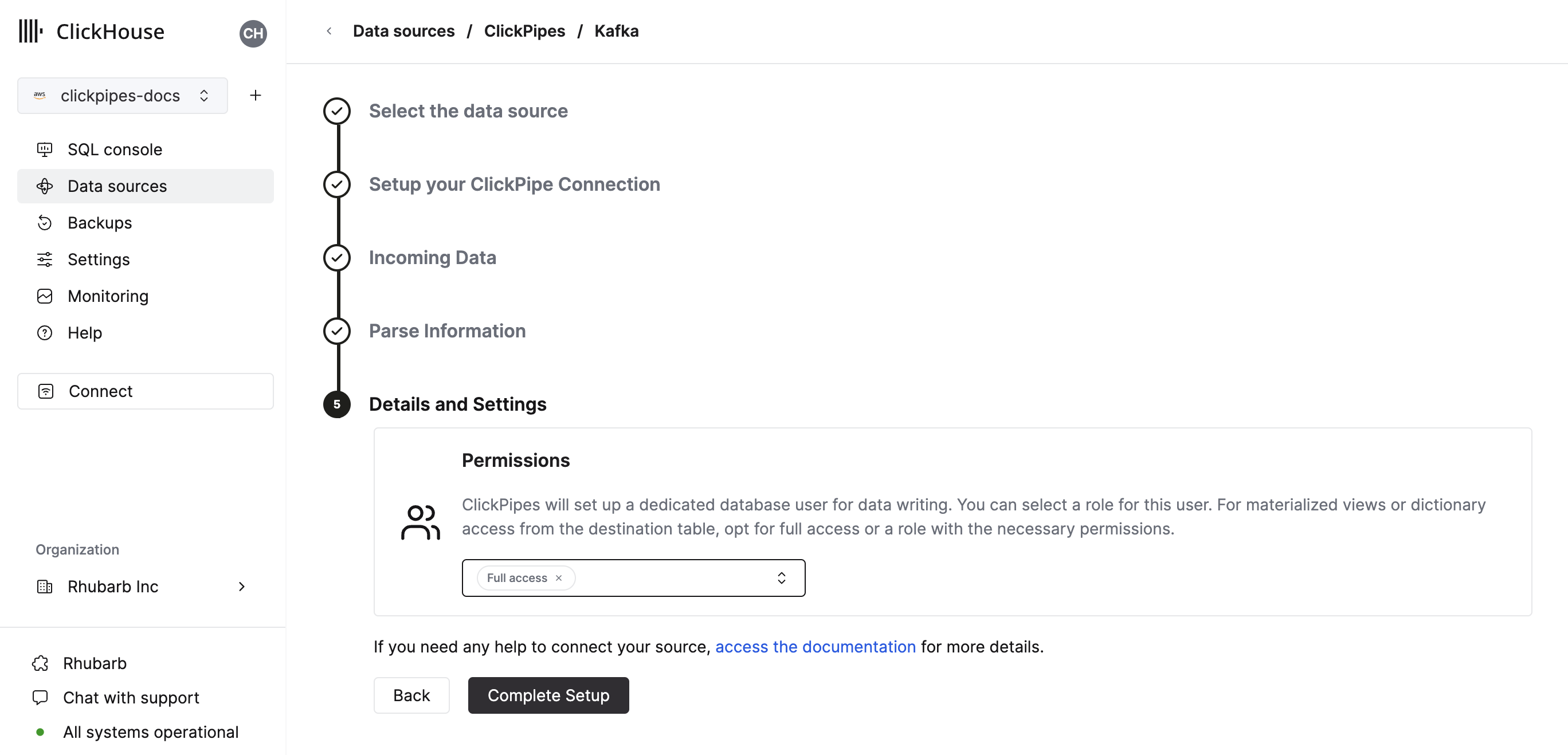

配置权限

最后,您可以为内部 ClickPipes 用户配置权限。

权限: ClickPipes 会创建一个专用用户,用于向目标表写入数据。您可以为该内部用户选择一个角色,可以是自定义角色或预定义角色之一:

Full access:对整个集群具有完全访问权限。如果您在目标表上使用物化视图或 Dictionary,则需要选择此角色。Only destination table:仅对目标表具有INSERT权限。

完成设置

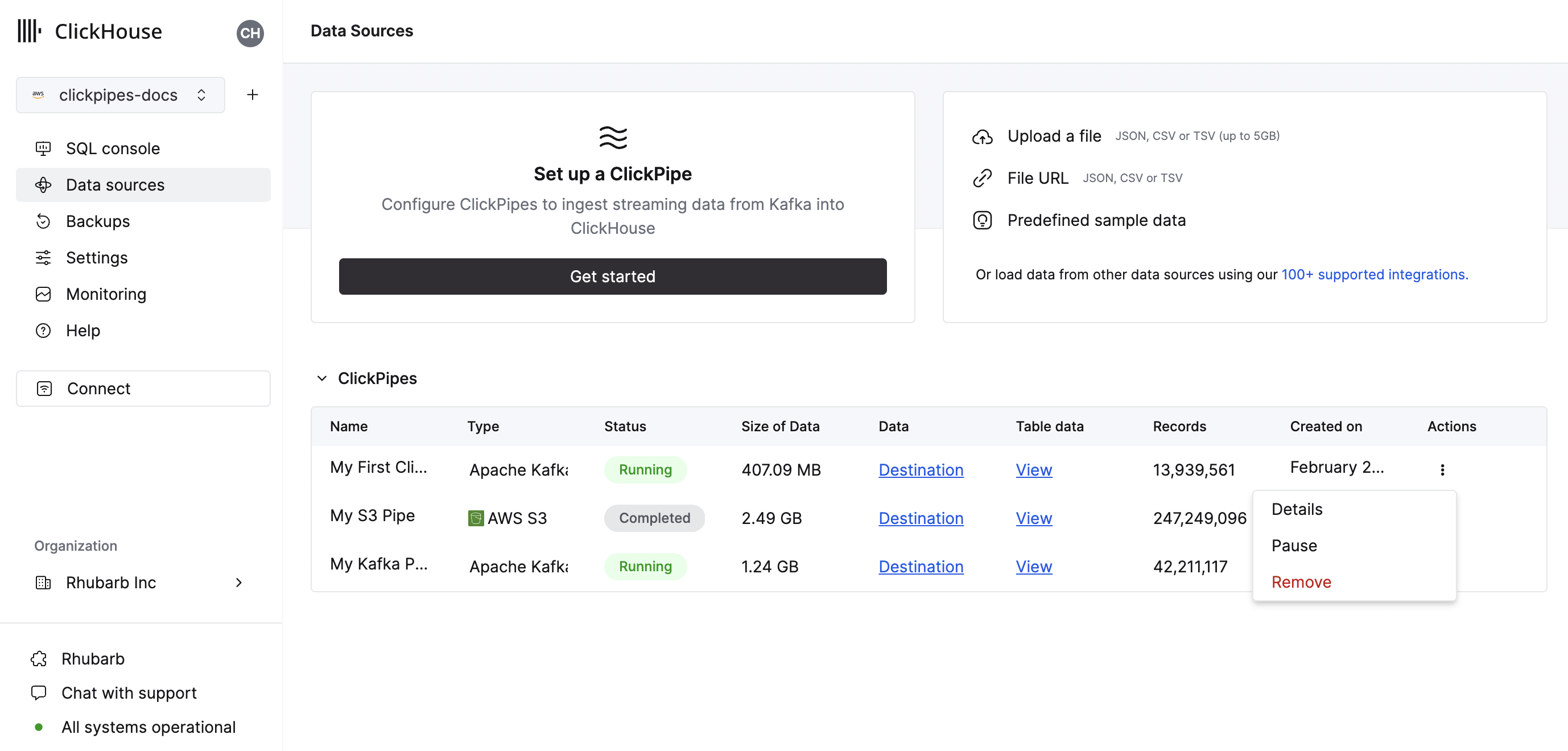

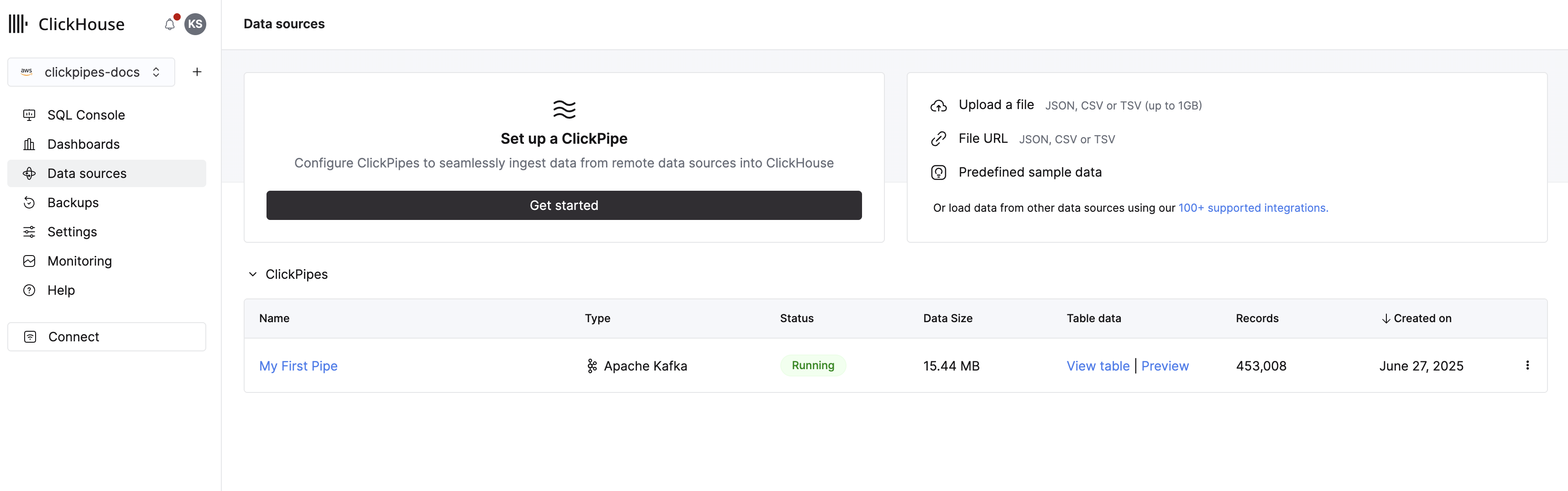

点击“Complete Setup”后,系统会注册你的 ClickPipe,你就可以在汇总表中看到它的条目。

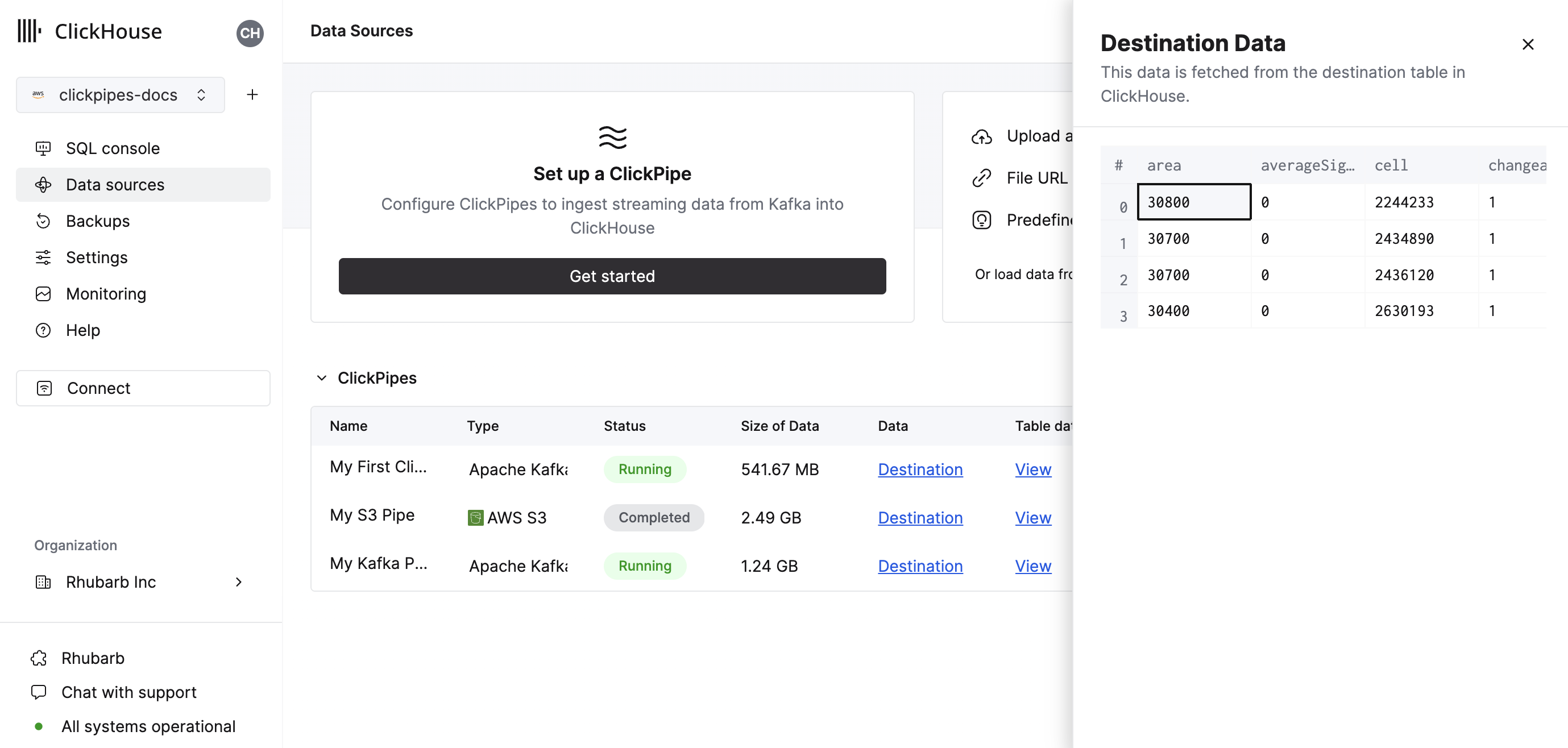

汇总表提供操作项,用于显示来自源或 ClickHouse 中目标表的示例数据。

同时还提供操作项,用于移除该 ClickPipe 并显示摄取任务的概要信息。

恭喜! 你已成功完成第一个 ClickPipe 的设置。 如果这是一个流式 ClickPipe,它将持续运行,从你的远程数据源实时摄取数据。 否则,它会完成该批次数据的摄取后自动结束。