Анализ данных Stack Overflow с помощью ClickHouse

Этот набор данных содержит все записи таблиц Posts, Users, Votes, Comments, Badges, PostHistory и PostLinks, которые когда‑либо появлялись на Stack Overflow.

Вы можете либо скачать заранее подготовленные версии данных в формате Parquet, содержащие все посты вплоть до апреля 2024 года включительно, либо скачать самые свежие данные в формате XML и загрузить их. Stack Overflow периодически обновляет эти данные — исторически примерно раз в 3 месяца.

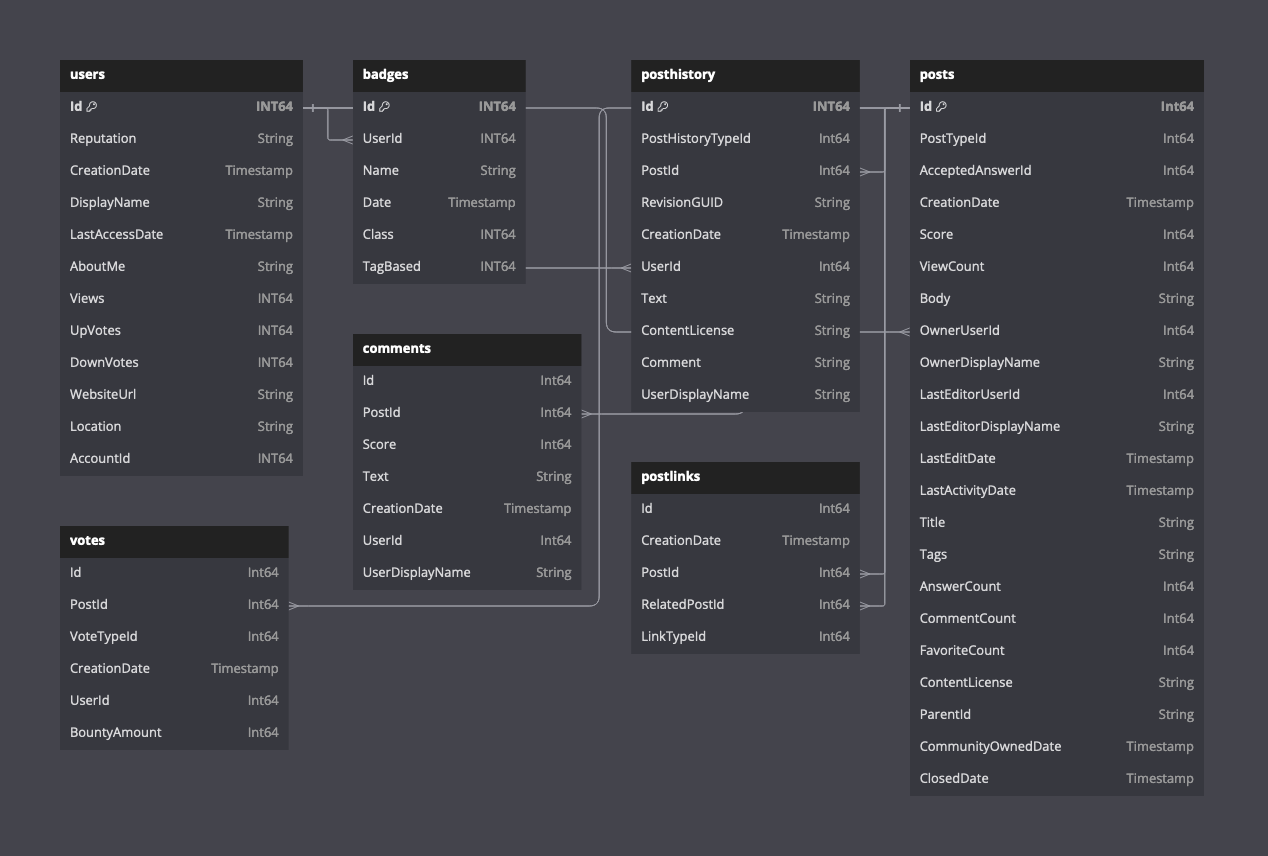

Следующая диаграмма показывает схему доступных таблиц при использовании формата Parquet.

Описание схемы этих данных можно найти здесь.

Предварительно подготовленные данные

Мы предоставляем копию этих данных в формате Parquet, актуальную по состоянию на апрель 2024 года. Хотя этот набор данных и невелик для ClickHouse по числу строк (60 миллионов публикаций), он содержит значительный объем текстов и крупные столбцы типа String.

CREATE DATABASE stackoverflow

Приведённые ниже временные показатели получены для кластера ClickHouse Cloud с 96 ГиБ ОЗУ и 24 vCPU, расположенного в eu-west-2. Набор данных находится в eu-west-3.

Публикации

CREATE TABLE stackoverflow.posts

(

`Id` Int32 CODEC(Delta(4), ZSTD(1)),

`PostTypeId` Enum8('Question' = 1, 'Answer' = 2, 'Wiki' = 3, 'TagWikiExcerpt' = 4, 'TagWiki' = 5, 'ModeratorNomination' = 6, 'WikiPlaceholder' = 7, 'PrivilegeWiki' = 8),

`AcceptedAnswerId` UInt32,

`CreationDate` DateTime64(3, 'UTC'),

`Score` Int32,

`ViewCount` UInt32 CODEC(Delta(4), ZSTD(1)),

`Body` String,

`OwnerUserId` Int32,

`OwnerDisplayName` String,

`LastEditorUserId` Int32,

`LastEditorDisplayName` String,

`LastEditDate` DateTime64(3, 'UTC') CODEC(Delta(8), ZSTD(1)),

`LastActivityDate` DateTime64(3, 'UTC'),

`Title` String,

`Tags` String,

`AnswerCount` UInt16 CODEC(Delta(2), ZSTD(1)),

`CommentCount` UInt8,

`FavoriteCount` UInt8,

`ContentLicense` LowCardinality(String),

`ParentId` String,

`CommunityOwnedDate` DateTime64(3, 'UTC'),

`ClosedDate` DateTime64(3, 'UTC')

)

ENGINE = MergeTree

PARTITION BY toYear(CreationDate)

ORDER BY (PostTypeId, toDate(CreationDate), CreationDate)

INSERT INTO stackoverflow.posts SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/posts/*.parquet')

0 rows in set. Elapsed: 265.466 sec. Processed 59.82 million rows, 38.07 GB (225.34 thousand rows/s., 143.42 MB/s.)

Посты также доступны по годам, например, по адресу: https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/posts/2020.parquet

Голоса

CREATE TABLE stackoverflow.votes

(

`Id` UInt32,

`PostId` Int32,

`VoteTypeId` UInt8,

`CreationDate` DateTime64(3, 'UTC'),

`UserId` Int32,

`BountyAmount` UInt8

)

ENGINE = MergeTree

ORDER BY (VoteTypeId, CreationDate, PostId, UserId)

INSERT INTO stackoverflow.votes SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/votes/*.parquet')

0 rows in set. Elapsed: 21.605 sec. Processed 238.98 million rows, 2.13 GB (11.06 million rows/s., 98.46 MB/s.)

Голоса также доступны по годам, например: https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/votes/2020.parquet

CREATE TABLE stackoverflow.comments

(

`Id` UInt32,

`PostId` UInt32,

`Score` UInt16,

`Text` String,

`CreationDate` DateTime64(3, 'UTC'),

`UserId` Int32,

`UserDisplayName` LowCardinality(String)

)

ENGINE = MergeTree

ORDER BY CreationDate

INSERT INTO stackoverflow.comments SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/comments/*.parquet')

0 rows in set. Elapsed: 56.593 sec. Processed 90.38 million rows, 11.14 GB (1.60 million rows/s., 196.78 MB/s.)

Комментарии также доступны по годам, например, https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/comments/2020.parquet

Пользователи

CREATE TABLE stackoverflow.users

(

`Id` Int32,

`Reputation` LowCardinality(String),

`CreationDate` DateTime64(3, 'UTC') CODEC(Delta(8), ZSTD(1)),

`DisplayName` String,

`LastAccessDate` DateTime64(3, 'UTC'),

`AboutMe` String,

`Views` UInt32,

`UpVotes` UInt32,

`DownVotes` UInt32,

`WebsiteUrl` String,

`Location` LowCardinality(String),

`AccountId` Int32

)

ENGINE = MergeTree

ORDER BY (Id, CreationDate)

INSERT INTO stackoverflow.users SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/users.parquet')

0 rows in set. Elapsed: 10.988 sec. Processed 22.48 million rows, 1.36 GB (2.05 million rows/s., 124.10 MB/s.)

Значки

CREATE TABLE stackoverflow.badges

(

`Id` UInt32,

`UserId` Int32,

`Name` LowCardinality(String),

`Date` DateTime64(3, 'UTC'),

`Class` Enum8('Gold' = 1, 'Silver' = 2, 'Bronze' = 3),

`TagBased` Bool

)

ENGINE = MergeTree

ORDER BY UserId

INSERT INTO stackoverflow.badges SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/badges.parquet')

0 rows in set. Elapsed: 6.635 sec. Processed 51.29 million rows, 797.05 MB (7.73 million rows/s., 120.13 MB/s.)

Ссылки на сообщения

CREATE TABLE stackoverflow.postlinks

(

`Id` UInt64,

`CreationDate` DateTime64(3, 'UTC'),

`PostId` Int32,

`RelatedPostId` Int32,

`LinkTypeId` Enum8('Linked' = 1, 'Duplicate' = 3)

)

ENGINE = MergeTree

ORDER BY (PostId, RelatedPostId)

INSERT INTO stackoverflow.postlinks SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/postlinks.parquet')

0 rows in set. Elapsed: 1.534 sec. Processed 6.55 million rows, 129.70 MB (4.27 million rows/s., 84.57 MB/s.)

PostHistory

CREATE TABLE stackoverflow.posthistory

(

`Id` UInt64,

`PostHistoryTypeId` UInt8,

`PostId` Int32,

`RevisionGUID` String,

`CreationDate` DateTime64(3, 'UTC'),

`UserId` Int32,

`Text` String,

`ContentLicense` LowCardinality(String),

`Comment` String,

`UserDisplayName` String

)

ENGINE = MergeTree

ORDER BY (CreationDate, PostId)

INSERT INTO stackoverflow.posthistory SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/posthistory/*.parquet')

0 rows in set. Elapsed: 422.795 sec. Processed 160.79 million rows, 67.08 GB (380.30 thousand rows/s., 158.67 MB/s.)

Исходный набор данных

Исходный набор данных доступен в сжатом XML-формате (7zip) по адресу https://archive.org/download/stackexchange — файлы с префиксом stackoverflow.com*.

Скачивание

wget https://archive.org/download/stackexchange/stackoverflow.com-Badges.7z

wget https://archive.org/download/stackexchange/stackoverflow.com-Comments.7z

wget https://archive.org/download/stackexchange/stackoverflow.com-PostHistory.7z

wget https://archive.org/download/stackexchange/stackoverflow.com-PostLinks.7z

wget https://archive.org/download/stackexchange/stackoverflow.com-Posts.7z

wget https://archive.org/download/stackexchange/stackoverflow.com-Users.7z

wget https://archive.org/download/stackexchange/stackoverflow.com-Votes.7z

Эти файлы могут иметь размер до 35 ГБ, и их скачивание может занять около 30 минут в зависимости от интернет-соединения — сервер загрузки ограничивает скорость примерно до 20 МБ/с.

Преобразование в JSON

На момент написания ClickHouse не имеет встроенной поддержки XML как входного формата. Чтобы загрузить данные в ClickHouse, мы сначала преобразуем их в NDJSON.

Для преобразования XML в JSON мы рекомендуем утилиту для Linux xq — это простая обёртка вокруг jq для работы с XML‑документами.

Установите xq и jq:

sudo apt install jq

pip install yq

Следующие шаги применимы к любому из вышеперечисленных файлов. В качестве примера используется файл stackoverflow.com-Posts.7z. При необходимости адаптируйте их под свою ситуацию.

Извлеките файл с помощью p7zip. В результате будет создан один XML‑файл — в данном случае Posts.xml.

Файлы сжаты примерно в 4,5 раза. При размере 22 ГБ в сжатом виде файл с постами занимает около 97 ГБ в несжатом виде.

p7zip -d stackoverflow.com-Posts.7z

Следующий запрос разбивает XML-файл на файлы по 10000 строк каждый.

mkdir posts

cd posts

# the following splits the input xml file into sub files of 10000 rows

tail +3 ../Posts.xml | head -n -1 | split -l 10000 --filter='{ printf "<rows>\n"; cat - ; printf "</rows>\n"; } > $FILE' -

После выполнения приведённой выше команды у вас будет набор файлов, каждый из которых содержит 10000 строк. Это гарантирует, что затраты памяти для следующей команды не будут чрезмерными (преобразование XML в JSON выполняется в памяти).

find . -maxdepth 1 -type f -exec xq -c '.rows.row[]' {} \; | sed -e 's:"@:":g' > posts_v2.json

Приведённая выше команда создаст один файл posts.json.

Загрузите его в ClickHouse с помощью следующей команды. Обратите внимание, что схема указана для файла posts.json. Её потребуется скорректировать в соответствии с типами данных, чтобы она соответствовала целевой таблице.

clickhouse local --query "SELECT * FROM file('posts.json', JSONEachRow, 'Id Int32, PostTypeId UInt8, AcceptedAnswerId UInt32, CreationDate DateTime64(3, \'UTC\'), Score Int32, ViewCount UInt32, Body String, OwnerUserId Int32, OwnerDisplayName String, LastEditorUserId Int32, LastEditorDisplayName String, LastEditDate DateTime64(3, \'UTC\'), LastActivityDate DateTime64(3, \'UTC\'), Title String, Tags String, AnswerCount UInt16, CommentCount UInt8, FavoriteCount UInt8, ContentLicense String, ParentId String, CommunityOwnedDate DateTime64(3, \'UTC\'), ClosedDate DateTime64(3, \'UTC\')') FORMAT Native" | clickhouse client --host <host> --secure --password <password> --query "INSERT INTO stackoverflow.posts_v2 FORMAT Native"

Примеры запросов

Несколько простых запросов для начала.

SELECT

arrayJoin(arrayFilter(t -> (t != ''), splitByChar('|', Tags))) AS Tags,

count() AS c

FROM stackoverflow.posts

GROUP BY Tags

ORDER BY c DESC

LIMIT 10

┌─Tags───────┬───────c─┐

│ javascript │ 2527130 │

│ python │ 2189638 │

│ java │ 1916156 │

│ c# │ 1614236 │

│ php │ 1463901 │

│ android │ 1416442 │

│ html │ 1186567 │

│ jquery │ 1034621 │

│ c++ │ 806202 │

│ css │ 803755 │

└────────────┴─────────┘

10 rows in set. Elapsed: 1.013 sec. Processed 59.82 million rows, 1.21 GB (59.07 million rows/s., 1.19 GB/s.)

Peak memory usage: 224.03 MiB.

Пользователь с наибольшим числом ответов (активные учетные записи)

Для учетной записи требуется UserId.

SELECT

any(OwnerUserId) UserId,

OwnerDisplayName,

count() AS c

FROM stackoverflow.posts WHERE OwnerDisplayName != '' AND PostTypeId='Answer' AND OwnerUserId != 0

GROUP BY OwnerDisplayName

ORDER BY c DESC

LIMIT 5

┌─UserId─┬─OwnerDisplayName─┬────c─┐

│ 22656 │ Jon Skeet │ 2727 │

│ 23354 │ Marc Gravell │ 2150 │

│ 12950 │ tvanfosson │ 1530 │

│ 3043 │ Joel Coehoorn │ 1438 │

│ 10661 │ S.Lott │ 1087 │

└────────┴──────────────────┴──────┘

5 rows in set. Elapsed: 0.154 sec. Processed 35.83 million rows, 193.39 MB (232.33 million rows/s., 1.25 GB/s.)

Peak memory usage: 206.45 MiB.

Самые просматриваемые посты о ClickHouse

SELECT

Id,

Title,

ViewCount,

AnswerCount

FROM stackoverflow.posts

WHERE Title ILIKE '%ClickHouse%'

ORDER BY ViewCount DESC

LIMIT 10

┌───────Id─┬─Title────────────────────────────────────────────────────────────────────────────┬─ViewCount─┬─AnswerCount─┐

│ 52355143 │ Is it possible to delete old records from clickhouse table? │ 41462 │ 3 │

│ 37954203 │ Clickhouse Data Import │ 38735 │ 3 │

│ 37901642 │ Updating data in Clickhouse │ 36236 │ 6 │

│ 58422110 │ Pandas: How to insert dataframe into Clickhouse │ 29731 │ 4 │

│ 63621318 │ DBeaver - Clickhouse - SQL Error [159] .. Read timed out │ 27350 │ 1 │

│ 47591813 │ How to filter clickhouse table by array column contents? │ 27078 │ 2 │

│ 58728436 │ How to search the string in query with case insensitive on Clickhouse database? │ 26567 │ 3 │

│ 65316905 │ Clickhouse: DB::Exception: Memory limit (for query) exceeded │ 24899 │ 2 │

│ 49944865 │ How to add a column in clickhouse │ 24424 │ 1 │

│ 59712399 │ How to cast date Strings to DateTime format with extended parsing in ClickHouse? │ 22620 │ 1 │

└──────────┴──────────────────────────────────────────────────────────────────────────────────┴───────────┴─────────────┘

10 rows in set. Elapsed: 0.472 sec. Processed 59.82 million rows, 1.91 GB (126.63 million rows/s., 4.03 GB/s.)

Peak memory usage: 240.01 MiB.

Самые резонансные публикации

SELECT

Id,

Title,

UpVotes,

DownVotes,

abs(UpVotes - DownVotes) AS Controversial_ratio

FROM stackoverflow.posts

INNER JOIN

(

SELECT

PostId,

countIf(VoteTypeId = 2) AS UpVotes,

countIf(VoteTypeId = 3) AS DownVotes

FROM stackoverflow.votes

GROUP BY PostId

HAVING (UpVotes > 10) AND (DownVotes > 10)

) AS votes ON posts.Id = votes.PostId

WHERE Title != ''

ORDER BY Controversial_ratio ASC

LIMIT 3

┌───────Id─┬─Title─────────────────────────────────────────────┬─UpVotes─┬─DownVotes─┬─Controversial_ratio─┐

│ 583177 │ VB.NET Infinite For Loop │ 12 │ 12 │ 0 │

│ 9756797 │ Read console input as enumerable - one statement? │ 16 │ 16 │ 0 │

│ 13329132 │ What's the point of ARGV in Ruby? │ 22 │ 22 │ 0 │

└──────────┴───────────────────────────────────────────────────┴─────────┴───────────┴─────────────────────┘

3 rows in set. Elapsed: 4.779 sec. Processed 298.80 million rows, 3.16 GB (62.52 million rows/s., 661.05 MB/s.)

Peak memory usage: 6.05 GiB.

Атрибуция

Мы благодарим Stack Overflow за предоставление этих данных по лицензии CC BY-SA 4.0, признавая их вклад и указывая на оригинальный источник данных по адресу https://archive.org/details/stackexchange.