LibreChatでClickHouse MCPサーバーを使用する

本ガイドでは、Dockerを使用してLibreChatとClickHouse MCPサーバーをセットアップし、 ClickHouseのサンプルデータセットに接続する方法を説明します。

Docker をインストールする

LibreChat と MCP サーバーを実行するには Docker が必要です。Docker を入手するには:

- docker.com にアクセスしてください

- お使いの OS 向けの Docker Desktop をダウンロードしてください

- お使いのオペレーティングシステム向けの手順に従って、Docker をインストールしてください

- Docker Desktop を起動し、実行中であることを確認します

詳細については、Docker ドキュメントを参照してください。

LibreChat リポジトリをクローンする

ターミナル(コマンドプロンプト、ターミナル、または PowerShell)を開き、次のコマンドを使用して LibreChat リポジトリをクローンします。

.env ファイルを作成して編集する

サンプル設定ファイルを .env.example から .env にコピーします:

お好みのテキストエディタで .env ファイルを開きます。OpenAI、Anthropic、AWS Bedrock など、

多くの主要な LLM プロバイダーのセクションが表示されます。例えば次のようになります。

user_provided を、使用したい LLM プロバイダーの API キーに置き換えます。

API キーをお持ちでない場合は、Ollama のようなローカル LLM を使用できます。これについては、 後の手順 "Ollama をインストールする" で説明します。今のところ .env ファイルは変更せず、次の手順に進んでください。

Docker Compose に ClickHouse MCP サーバーを追加する

次に、LLM が ClickHouse SQL playground と対話できるようにするため、ClickHouse MCP サーバーを LibreChat の Docker Compose ファイルに追加します。

docker-compose.override.yml という名前のファイルを作成し、次の設定を追加します。

独自のデータを探索したい場合は、ご利用の ClickHouse Cloud サービスの ホスト名、ユーザー名、パスワード を使用して接続できます。

librechat.yaml で MCP サーバーを設定する

librechat.yaml を開き、ファイルの末尾に次の設定を追加します。

これにより、Docker 上で実行されている MCP サーバーに LibreChat が接続するように設定されます。

次の行を見つけてください。

簡略化のため、ここでは認証を一旦無効にします。

Ollama を使用してローカル LLM を追加する(オプション)

Ollama をインストールする

Ollama ウェブサイトにアクセスし、お使いのシステム用の Ollama をインストールしてください。

インストール後、次のようにモデルを実行できます:

これにより、モデルがローカルマシンに存在しない場合、プルが実行されます。

モデルの一覧については、Ollama ライブラリを参照してください

librechat.yaml で Ollama を設定する

モデルのダウンロードが完了したら、librechat.yaml で設定します:

ブラウザで LibreChat を開く

すべてのサービスが起動して実行されたら、ブラウザを開いて http://localhost:3080/ にアクセスしてください。

まだアカウントをお持ちでない場合は、無料の LibreChat アカウントを作成してサインインします。ClickHouse MCP サーバーに接続された LibreChat インターフェースが表示され、オプションでローカル LLM も利用できるようになります。

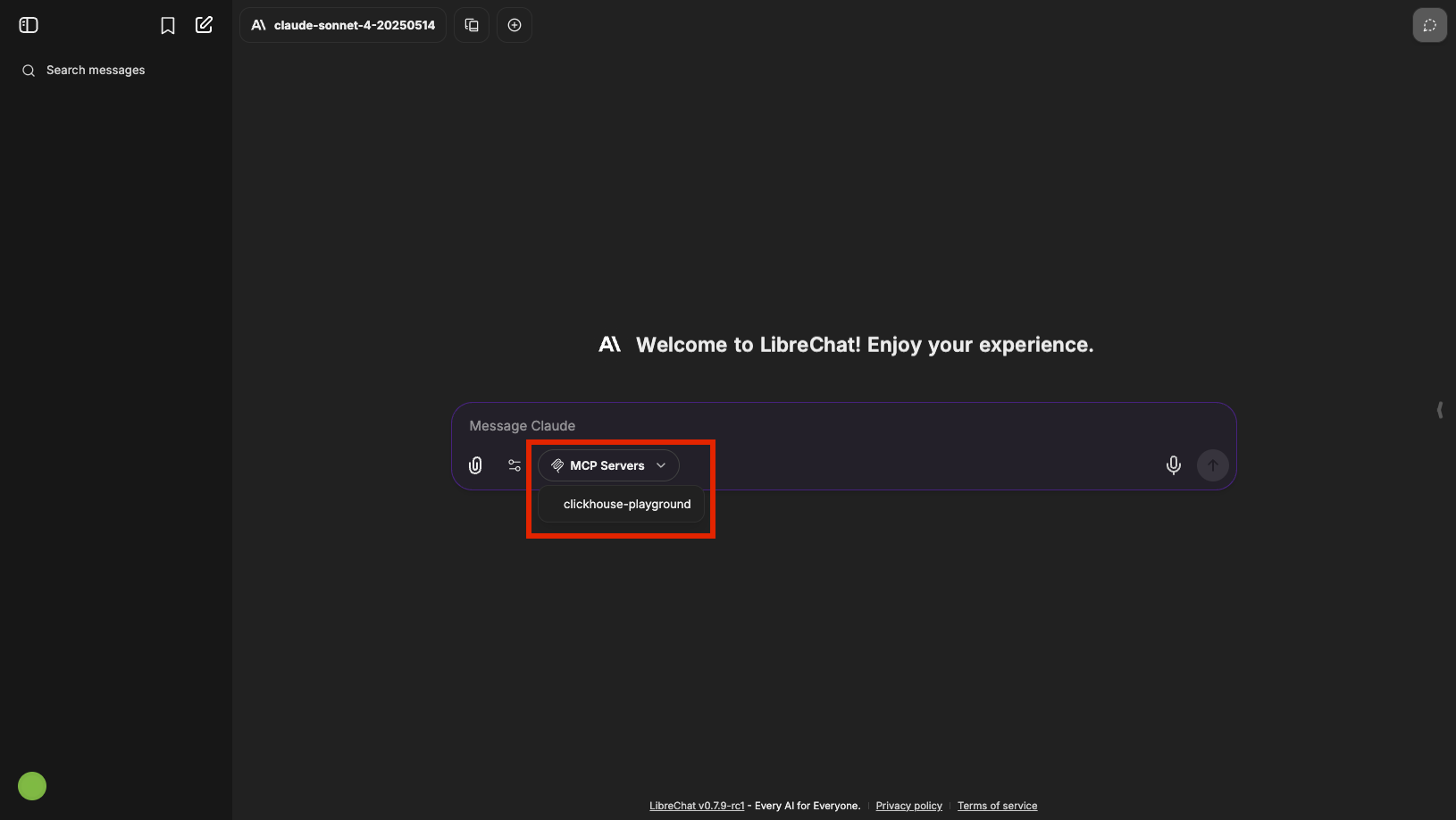

チャットインターフェースから、MCP サーバーとして clickhouse-playground を選択します:

これで、LLM に ClickHouse のサンプルデータセットを探索するよう指示できます。試してみましょう:

LibreChat の UI に MCP サーバーのオプションが表示されない場合は、

librechat.yaml ファイルで適切な権限が設定されているか確認してください。

interface セクション内の mcpServers で use が false に設定されている場合、チャット画面に MCP 選択用ドロップダウンは表示されません。