Amazon Glue を ClickHouse および Spark と統合する

ClickHouse Supported

Amazon Glue は、Amazon Web Services (AWS) が提供するフルマネージドなサーバーレスのデータ統合サービスです。分析、機械学習、アプリケーション開発のためのデータの検出、準備、変換といった処理を簡素化します。

インストール

Glue のコードを ClickHouse と連携させるには、次のいずれかの方法で Glue から公式 Spark コネクタを利用できます。

- AWS Marketplace から ClickHouse Glue コネクタをインストールする(推奨)。

- Spark コネクタの JAR を手動で Glue ジョブに追加する。

- AWS Marketplace

- Manual Installation

-

コネクタをサブスクライブする

自分のアカウントでコネクタにアクセスするには、AWS Marketplace から ClickHouse AWS Glue Connector をサブスクライブします。 -

必要な権限を付与する

Glue ジョブの IAM ロールに、最小権限のガイドで説明されている必要な権限が付与されていることを確認します。 -

コネクタを有効化して接続を作成する

このリンクをクリックすると、主要な項目があらかじめ入力された状態で Glue の接続作成ページが開き、そこからコネクタを有効化して接続を作成できます。接続に名前を付けて「作成」をクリックします(この段階では ClickHouse の接続情報を入力する必要はありません)。 -

Glue ジョブでの利用

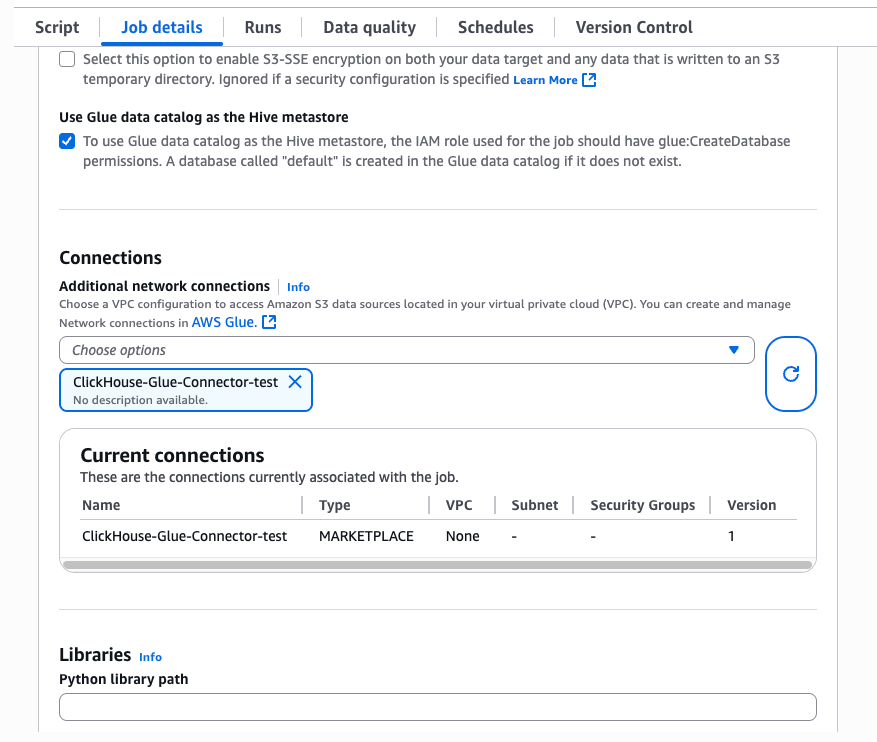

Glue ジョブでJob detailsタブを選択し、Advanced propertiesウィンドウを展開します。Connectionsセクションで、先ほど作成した接続を選択します。コネクタは、必要な JAR をジョブのランタイムに自動的に注入します。

注記

Glue コネクタで使用される JAR は、Spark 3.3、Scala 2、Python 3 向けにビルドされています。Glue ジョブを設定する際は、必ずこれらのバージョンを選択してください。

必要な JAR を手動で追加するには、次の手順に従ってください。

- 次の JAR を S3 バケットにアップロードします:

clickhouse-jdbc-0.6.X-all.jarとclickhouse-spark-runtime-3.X_2.X-0.8.X.jar。 - Glue ジョブがこのバケットにアクセスできることを確認します。

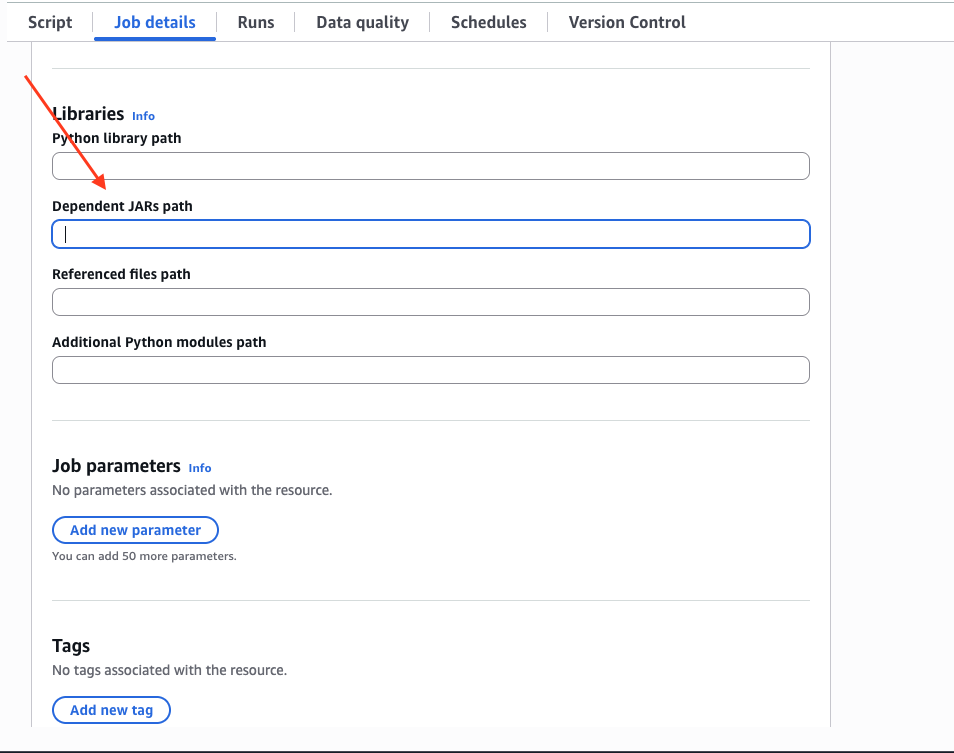

Job detailsタブで下にスクロールし、Advanced propertiesドロップダウンを展開して、Dependent JARs pathに JAR のパスを入力します。

使用例

- Scala(スカラ)

- Python

詳しくは、Spark のドキュメントをご覧ください。