Azure Synapse と ClickHouse の連携

Azure Synapse は、ビッグデータ、データサイエンス、データウェアハウスを統合した分析サービスであり、高速かつ大規模なデータ分析を可能にします。 Synapse 内では、Spark プールがオンデマンドかつスケーラブルな Apache Spark クラスターを提供し、複雑なデータ変換や機械学習、外部システムとの連携を実行できます。

この記事では、Azure Synapse 内で Apache Spark を利用する際に、ClickHouse Spark connector と連携させる方法を説明します。

コネクタの依存関係を追加する

Azure Synapse では、次の 3 つのレベルでのパッケージ管理がサポートされています:

- 既定のパッケージ

- Spark プール レベル

- セッション レベル

「Manage libraries for Apache Spark pools」ガイドに従い、次の必須となる依存関係を Spark アプリケーションに追加します。

clickhouse-spark-runtime-{spark_version}_{scala_version}-{connector_version}.jar- 公式 Mavenclickhouse-jdbc-{java_client_version}-all.jar- 公式 Maven

どのバージョンが要件に適合するかを確認するには、Spark Connector Compatibility Matrix ドキュメントを参照してください。

ClickHouse をカタログとして追加する

セッションに Spark の設定を追加する方法はいくつかあります。

- セッションで読み込むカスタム設定ファイルを使用する

- Azure Synapse の UI から設定を追加する

- Synapse ノートブック内で設定を追加する

Manage Apache Spark configuration に従い、このコネクタに必要な Spark 設定を追加します。

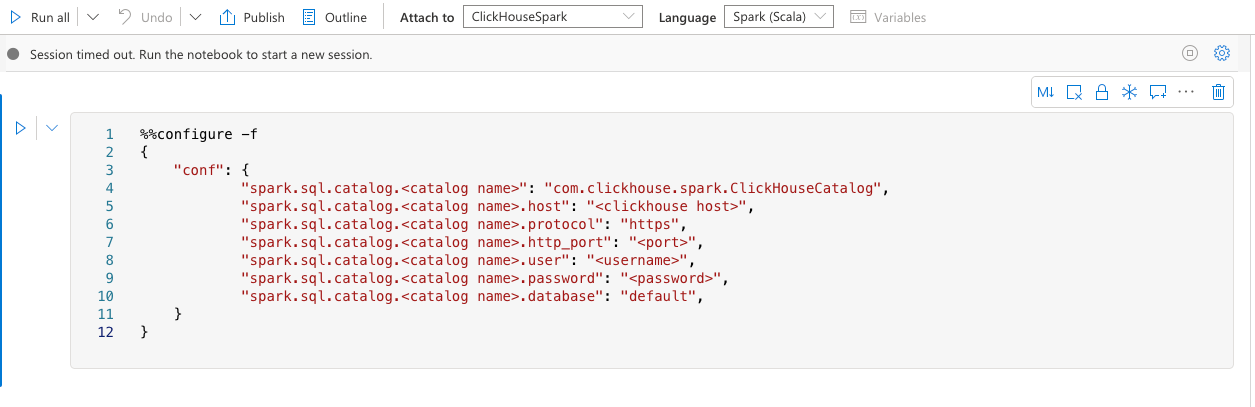

たとえば、ノートブック内で次の設定を使って Spark セッションを構成できます。

以下のように必ず最初のセルに設定してください:

追加の設定については、ClickHouse Spark 設定ページを参照してください。

ClickHouse Cloud を利用する場合は、必ず 必須の Spark 設定を行ってください。

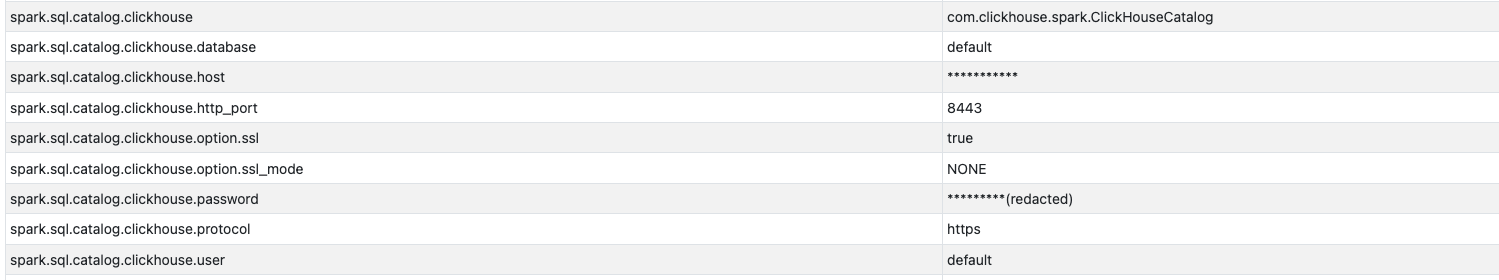

セットアップの検証

依存関係および設定が正しく構成されていることを確認するには、該当セッションの Spark UI を開き、Environment タブを表示します。

そこで、ClickHouse に関連する設定を探します。