ClickHouse を使った Stack Overflow データの分析

このデータセットには、Stack Overflow 上で発生したすべての Posts、Users、Votes、Comments、Badges、PostHistory、および PostLinks が含まれています。

2024 年 4 月までの全投稿を含む、事前に用意された Parquet 形式のデータをダウンロードするか、最新のデータを XML 形式でダウンロードして読み込むことができます。Stack Overflow はこのデータを定期的に更新しており、これまでのところおおよそ 3 か月ごとに公開されています。

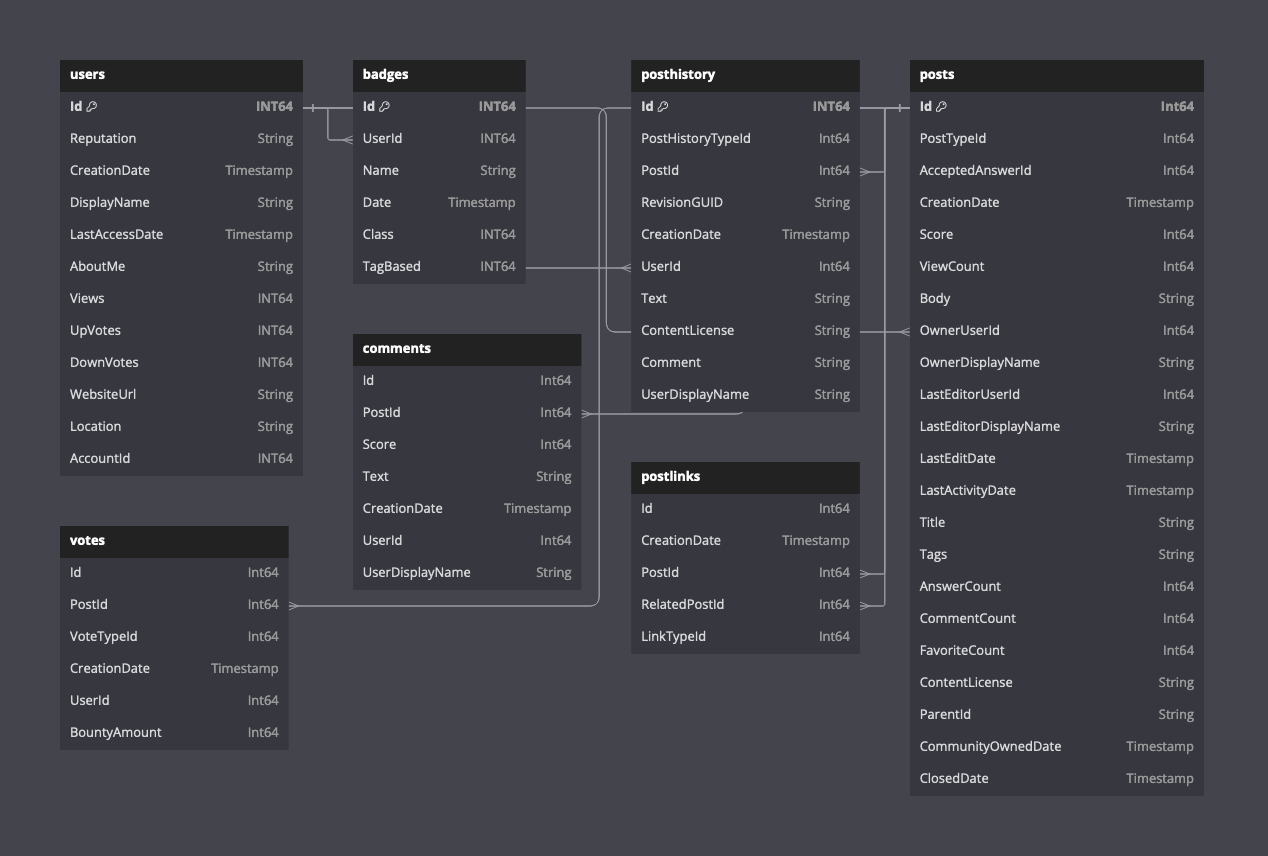

以下の図は、Parquet 形式を前提とした利用可能なテーブルのスキーマを示しています。

このデータのスキーマの説明はこちらにあります。

事前に用意されたデータ

このデータのコピーを Parquet 形式で提供しており、内容は 2024 年 4 月時点のものです。行数(投稿 6,000 万件)だけを見れば ClickHouse にとっては小規模ですが、このデータセットには大量のテキストとサイズの大きい String 型カラムが含まれています。

CREATE DATABASE stackoverflow

以下の計測値は、eu-west-2 にある 96 GiB、24 vCPU の ClickHouse Cloud クラスターに対するものです。データセットは eu-west-3 にあります。

CREATE TABLE stackoverflow.posts

(

`Id` Int32 CODEC(Delta(4), ZSTD(1)),

`PostTypeId` Enum8('Question' = 1, 'Answer' = 2, 'Wiki' = 3, 'TagWikiExcerpt' = 4, 'TagWiki' = 5, 'ModeratorNomination' = 6, 'WikiPlaceholder' = 7, 'PrivilegeWiki' = 8),

`AcceptedAnswerId` UInt32,

`CreationDate` DateTime64(3, 'UTC'),

`Score` Int32,

`ViewCount` UInt32 CODEC(Delta(4), ZSTD(1)),

`Body` String,

`OwnerUserId` Int32,

`OwnerDisplayName` String,

`LastEditorUserId` Int32,

`LastEditorDisplayName` String,

`LastEditDate` DateTime64(3, 'UTC') CODEC(Delta(8), ZSTD(1)),

`LastActivityDate` DateTime64(3, 'UTC'),

`Title` String,

`Tags` String,

`AnswerCount` UInt16 CODEC(Delta(2), ZSTD(1)),

`CommentCount` UInt8,

`FavoriteCount` UInt8,

`ContentLicense` LowCardinality(String),

`ParentId` String,

`CommunityOwnedDate` DateTime64(3, 'UTC'),

`ClosedDate` DateTime64(3, 'UTC')

)

ENGINE = MergeTree

PARTITION BY toYear(CreationDate)

ORDER BY (PostTypeId, toDate(CreationDate), CreationDate)

INSERT INTO stackoverflow.posts SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/posts/*.parquet')

0 rows in set. Elapsed: 265.466 sec. Processed 59.82 million rows, 38.07 GB (225.34 thousand rows/s., 143.42 MB/s.)

投稿データは年別のファイルとしても利用できます。例: https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/posts/2020.parquet

CREATE TABLE stackoverflow.votes

(

`Id` UInt32,

`PostId` Int32,

`VoteTypeId` UInt8,

`CreationDate` DateTime64(3, 'UTC'),

`UserId` Int32,

`BountyAmount` UInt8

)

ENGINE = MergeTree

ORDER BY (VoteTypeId, CreationDate, PostId, UserId)

INSERT INTO stackoverflow.votes SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/votes/*.parquet')

0 rows in set. Elapsed: 21.605 sec. Processed 238.98 million rows, 2.13 GB (11.06 million rows/s., 98.46 MB/s.)

投票データは年ごとのファイルも利用可能です。例: https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/votes/2020.parquet

CREATE TABLE stackoverflow.comments

(

`Id` UInt32,

`PostId` UInt32,

`Score` UInt16,

`Text` String,

`CreationDate` DateTime64(3, 'UTC'),

`UserId` Int32,

`UserDisplayName` LowCardinality(String)

)

ENGINE = MergeTree

ORDER BY CreationDate

INSERT INTO stackoverflow.comments SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/comments/*.parquet')

0 rows in set. Elapsed: 56.593 sec. Processed 90.38 million rows, 11.14 GB (1.60 million rows/s., 196.78 MB/s.)

コメントデータは年ごとにも利用できます。例: https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/comments/2020.parquet

ユーザー

CREATE TABLE stackoverflow.users

(

`Id` Int32,

`Reputation` LowCardinality(String),

`CreationDate` DateTime64(3, 'UTC') CODEC(Delta(8), ZSTD(1)),

`DisplayName` String,

`LastAccessDate` DateTime64(3, 'UTC'),

`AboutMe` String,

`Views` UInt32,

`UpVotes` UInt32,

`DownVotes` UInt32,

`WebsiteUrl` String,

`Location` LowCardinality(String),

`AccountId` Int32

)

ENGINE = MergeTree

ORDER BY (Id, CreationDate)

INSERT INTO stackoverflow.users SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/users.parquet')

0 rows in set. Elapsed: 10.988 sec. Processed 22.48 million rows, 1.36 GB (2.05 million rows/s., 124.10 MB/s.)

バッジ

CREATE TABLE stackoverflow.badges

(

`Id` UInt32,

`UserId` Int32,

`Name` LowCardinality(String),

`Date` DateTime64(3, 'UTC'),

`Class` Enum8('Gold' = 1, 'Silver' = 2, 'Bronze' = 3),

`TagBased` Bool

)

ENGINE = MergeTree

ORDER BY UserId

INSERT INTO stackoverflow.badges SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/badges.parquet')

0 rows in set. Elapsed: 6.635 sec. Processed 51.29 million rows, 797.05 MB (7.73 million rows/s., 120.13 MB/s.)

PostLinks

CREATE TABLE stackoverflow.postlinks

(

`Id` UInt64,

`CreationDate` DateTime64(3, 'UTC'),

`PostId` Int32,

`RelatedPostId` Int32,

`LinkTypeId` Enum8('Linked' = 1, 'Duplicate' = 3)

)

ENGINE = MergeTree

ORDER BY (PostId, RelatedPostId)

INSERT INTO stackoverflow.postlinks SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/postlinks.parquet')

0 rows in set. Elapsed: 1.534 sec. Processed 6.55 million rows, 129.70 MB (4.27 million rows/s., 84.57 MB/s.)

PostHistory(投稿履歴)

CREATE TABLE stackoverflow.posthistory

(

`Id` UInt64,

`PostHistoryTypeId` UInt8,

`PostId` Int32,

`RevisionGUID` String,

`CreationDate` DateTime64(3, 'UTC'),

`UserId` Int32,

`Text` String,

`ContentLicense` LowCardinality(String),

`Comment` String,

`UserDisplayName` String

)

ENGINE = MergeTree

ORDER BY (CreationDate, PostId)

INSERT INTO stackoverflow.posthistory SELECT * FROM s3('https://datasets-documentation.s3.eu-west-3.amazonaws.com/stackoverflow/parquet/posthistory/*.parquet')

0 rows in set. Elapsed: 422.795 sec. Processed 160.79 million rows, 67.08 GB (380.30 thousand rows/s., 158.67 MB/s.)

元のデータセット

元のデータセットは、圧縮済みの (7zip) XML 形式で https://archive.org/download/stackexchange から入手できます(stackoverflow.com* というプレフィックスが付いたファイル)。

ダウンロード

wget https://archive.org/download/stackexchange/stackoverflow.com-Badges.7z

wget https://archive.org/download/stackexchange/stackoverflow.com-Comments.7z

wget https://archive.org/download/stackexchange/stackoverflow.com-PostHistory.7z

wget https://archive.org/download/stackexchange/stackoverflow.com-PostLinks.7z

wget https://archive.org/download/stackexchange/stackoverflow.com-Posts.7z

wget https://archive.org/download/stackexchange/stackoverflow.com-Users.7z

wget https://archive.org/download/stackexchange/stackoverflow.com-Votes.7z

これらのファイルのサイズは最大 35GB あり、インターネット接続状況によってはダウンロードに約 30 分かかる場合があります。ダウンロードサーバー側で帯域制限がかけられており、速度はおおよそ 20MB/秒が上限です。

JSON への変換

本ドキュメント執筆時点では、ClickHouse には XML を入力フォーマットとしてネイティブにサポートする機能がありません。データを ClickHouse にロードするには、まず NDJSON 形式に変換します。

XML を JSON に変換するには、XML ドキュメント向けのシンプルな jq ラッパーである xq Linux 用ツールの利用を推奨します。

xq と jq をインストールします:

sudo apt install jq

pip install yq

以下の手順は、上記のいずれのファイルにも適用できます。ここでは例として stackoverflow.com-Posts.7z ファイルを使用します。必要に応じて読み替えてください。

p7zip を使用してファイルを展開します。これにより、1 つの xml ファイルが生成されます。この例では Posts.xml です。

ファイルはおよそ 4.5 倍に圧縮されています。圧縮サイズが 22GB の場合、投稿ファイルは展開後におよそ 97GB の容量が必要になります。

p7zip -d stackoverflow.com-Posts.7z

以下の例では、XML ファイルを複数のファイルに分割し、各ファイルに 10,000 行ずつ含めます。

mkdir posts

cd posts

# the following splits the input xml file into sub files of 10000 rows

tail +3 ../Posts.xml | head -n -1 | split -l 10000 --filter='{ printf "<rows>\n"; cat - ; printf "</rows>\n"; } > $FILE' -

上記を実行すると、各 10000 行のファイルからなる一連のファイルが作成されます。これは、次に実行するコマンドによるメモリオーバーヘッドが過大にならないようにするためです(XML から JSON への変換はメモリ上で行われます)。

find . -maxdepth 1 -type f -exec xq -c '.rows.row[]' {} \; | sed -e 's:"@:":g' > posts_v2.json

上記のコマンドを実行すると、単一の posts.json ファイルが生成されます。

次のコマンドで ClickHouse にロードします。posts.json ファイル用のスキーマが指定されている点に注意してください。対象テーブルのスキーマと整合するよう、データ型に応じて調整する必要があります。

clickhouse local --query "SELECT * FROM file('posts.json', JSONEachRow, 'Id Int32, PostTypeId UInt8, AcceptedAnswerId UInt32, CreationDate DateTime64(3, \'UTC\'), Score Int32, ViewCount UInt32, Body String, OwnerUserId Int32, OwnerDisplayName String, LastEditorUserId Int32, LastEditorDisplayName String, LastEditDate DateTime64(3, \'UTC\'), LastActivityDate DateTime64(3, \'UTC\'), Title String, Tags String, AnswerCount UInt16, CommentCount UInt8, FavoriteCount UInt8, ContentLicense String, ParentId String, CommunityOwnedDate DateTime64(3, \'UTC\'), ClosedDate DateTime64(3, \'UTC\')') FORMAT Native" | clickhouse client --host <host> --secure --password <password> --query "INSERT INTO stackoverflow.posts_v2 FORMAT Native"

クエリ例

最初の一歩として試せる、いくつかの簡単なクエリ例です。

SELECT

arrayJoin(arrayFilter(t -> (t != ''), splitByChar('|', Tags))) AS Tags,

count() AS c

FROM stackoverflow.posts

GROUP BY Tags

ORDER BY c DESC

LIMIT 10

┌─Tags───────┬───────c─┐

│ javascript │ 2527130 │

│ python │ 2189638 │

│ java │ 1916156 │

│ c# │ 1614236 │

│ php │ 1463901 │

│ android │ 1416442 │

│ html │ 1186567 │

│ jquery │ 1034621 │

│ c++ │ 806202 │

│ css │ 803755 │

└────────────┴─────────┘

10 rows in set. Elapsed: 1.013 sec. Processed 59.82 million rows, 1.21 GB (59.07 million rows/s., 1.19 GB/s.)

Peak memory usage: 224.03 MiB.

回答数が最も多いユーザー(アクティブアカウント)

アカウントには UserId が必要です。

SELECT

any(OwnerUserId) UserId,

OwnerDisplayName,

count() AS c

FROM stackoverflow.posts WHERE OwnerDisplayName != '' AND PostTypeId='Answer' AND OwnerUserId != 0

GROUP BY OwnerDisplayName

ORDER BY c DESC

LIMIT 5

┌─UserId─┬─OwnerDisplayName─┬────c─┐

│ 22656 │ Jon Skeet │ 2727 │

│ 23354 │ Marc Gravell │ 2150 │

│ 12950 │ tvanfosson │ 1530 │

│ 3043 │ Joel Coehoorn │ 1438 │

│ 10661 │ S.Lott │ 1087 │

└────────┴──────────────────┴──────┘

5 rows in set. Elapsed: 0.154 sec. Processed 35.83 million rows, 193.39 MB (232.33 million rows/s., 1.25 GB/s.)

Peak memory usage: 206.45 MiB.

ビュー数が最も多い ClickHouse 関連投稿

SELECT

Id,

Title,

ViewCount,

AnswerCount

FROM stackoverflow.posts

WHERE Title ILIKE '%ClickHouse%'

ORDER BY ViewCount DESC

LIMIT 10

┌───────Id─┬─Title────────────────────────────────────────────────────────────────────────────┬─ViewCount─┬─AnswerCount─┐

│ 52355143 │ Is it possible to delete old records from clickhouse table? │ 41462 │ 3 │

│ 37954203 │ Clickhouse Data Import │ 38735 │ 3 │

│ 37901642 │ Updating data in Clickhouse │ 36236 │ 6 │

│ 58422110 │ Pandas: How to insert dataframe into Clickhouse │ 29731 │ 4 │

│ 63621318 │ DBeaver - Clickhouse - SQL Error [159] .. Read timed out │ 27350 │ 1 │

│ 47591813 │ How to filter clickhouse table by array column contents? │ 27078 │ 2 │

│ 58728436 │ How to search the string in query with case insensitive on Clickhouse database? │ 26567 │ 3 │

│ 65316905 │ Clickhouse: DB::Exception: Memory limit (for query) exceeded │ 24899 │ 2 │

│ 49944865 │ How to add a column in clickhouse │ 24424 │ 1 │

│ 59712399 │ How to cast date Strings to DateTime format with extended parsing in ClickHouse? │ 22620 │ 1 │

└──────────┴──────────────────────────────────────────────────────────────────────────────────┴───────────┴─────────────┘

10 rows in set. Elapsed: 0.472 sec. Processed 59.82 million rows, 1.91 GB (126.63 million rows/s., 4.03 GB/s.)

Peak memory usage: 240.01 MiB.

最も物議を醸した投稿

SELECT

Id,

Title,

UpVotes,

DownVotes,

abs(UpVotes - DownVotes) AS Controversial_ratio

FROM stackoverflow.posts

INNER JOIN

(

SELECT

PostId,

countIf(VoteTypeId = 2) AS UpVotes,

countIf(VoteTypeId = 3) AS DownVotes

FROM stackoverflow.votes

GROUP BY PostId

HAVING (UpVotes > 10) AND (DownVotes > 10)

) AS votes ON posts.Id = votes.PostId

WHERE Title != ''

ORDER BY Controversial_ratio ASC

LIMIT 3

┌───────Id─┬─Title─────────────────────────────────────────────┬─UpVotes─┬─DownVotes─┬─Controversial_ratio─┐

│ 583177 │ VB.NET Infinite For Loop │ 12 │ 12 │ 0 │

│ 9756797 │ Read console input as enumerable - one statement? │ 16 │ 16 │ 0 │

│ 13329132 │ What's the point of ARGV in Ruby? │ 22 │ 22 │ 0 │

└──────────┴───────────────────────────────────────────────────┴─────────┴───────────┴─────────────────────┘

3 rows in set. Elapsed: 4.779 sec. Processed 298.80 million rows, 3.16 GB (62.52 million rows/s., 661.05 MB/s.)

Peak memory usage: 6.05 GiB.

帰属表示

このデータを cc-by-sa 4.0 ライセンスの下で提供している Stack Overflow に感謝するとともに、その貢献と、このデータの元となる情報源である https://archive.org/details/stackexchange をここに明記します。