- サンプルデータセット

- GitHub リポジトリ

GitHub データを用いた ClickHouse でのクエリの作成

このデータセットには、ClickHouse リポジトリに対するすべてのコミットと変更が含まれています。ClickHouse に同梱されているネイティブな git-import ツールを使用して生成できます。

生成されたデータでは、次の各テーブルごとに 1 つの tsv ファイルが生成されます。

commits- 統計情報を含むコミット。file_changes- 各コミットで変更されたファイルと、その変更内容および統計情報。line_changes- 各コミット内で変更されたすべてのファイルにおける、変更されたすべての行と、その行に関する詳細な情報、およびその行の前回の変更に関する情報。

2022 年 11 月 8 日時点で、各 TSV の概算サイズと行数は次のとおりです。

commits- 7.8M - 266,051 行file_changes- 53M - 266,051 行line_changes- 2.7G - 7,535,157 行

データの生成

これは任意です。データは無償で提供しているため、データのダウンロードと挿入を参照してください。

git clone [email protected]:ClickHouse/ClickHouse.git

cd ClickHouse

clickhouse git-import --skip-paths 'generated\.cpp|^(contrib|docs?|website|libs/(libcityhash|liblz4|libdivide|libvectorclass|libdouble-conversion|libcpuid|libzstd|libfarmhash|libmetrohash|libpoco|libwidechar_width))/' --skip-commits-with-messages '^Merge branch '

ClickHouse リポジトリの場合、完了までに約 3 分かかります(2022 年 11 月 8 日時点の MacBook Pro 2021 での測定)。

利用可能なオプションの完全な一覧は、ツールの組み込みヘルプから取得できます。

clickhouse git-import -h

このヘルプでは、上記の各テーブルに対する DDL も提供しています。例:

CREATE TABLE git.commits

(

hash String,

author LowCardinality(String),

time DateTime,

message String,

files_added UInt32,

files_deleted UInt32,

files_renamed UInt32,

files_modified UInt32,

lines_added UInt32,

lines_deleted UInt32,

hunks_added UInt32,

hunks_removed UInt32,

hunks_changed UInt32

) ENGINE = MergeTree ORDER BY time;

これらのクエリはどのリポジトリでも動作します。自由に試し、得られた知見を共有してください。 実行時間に関するいくつかの目安(2022年11月時点):

- Linux -

~/clickhouse git-import- 160分

データのダウンロードと挿入

以下のデータを使用して、動作する環境を再現できます。また、このデータセットは play.clickhouse.com でも利用できます。詳細については Queries を参照してください。

以下のリポジトリ向けに生成されたファイルは次のとおりです。

- ClickHouse (2022年11月8日)

- https://datasets-documentation.s3.amazonaws.com/github/commits/clickhouse/commits.tsv.xz - 2.5 MB

- https://datasets-documentation.s3.amazonaws.com/github/commits/clickhouse/file_changes.tsv.xz - 4.5 MB

- https://datasets-documentation.s3.amazonaws.com/github/commits/clickhouse/line_changes.tsv.xz - 127.4 MB

- Linux (2022年11月8日)

このデータを挿入するには、次のクエリを実行してデータベースを準備してください。

DROP DATABASE IF EXISTS git;

CREATE DATABASE git;

CREATE TABLE git.commits

(

hash String,

author LowCardinality(String),

time DateTime,

message String,

files_added UInt32,

files_deleted UInt32,

files_renamed UInt32,

files_modified UInt32,

lines_added UInt32,

lines_deleted UInt32,

hunks_added UInt32,

hunks_removed UInt32,

hunks_changed UInt32

) ENGINE = MergeTree ORDER BY time;

CREATE TABLE git.file_changes

(

change_type Enum('Add' = 1, 'Delete' = 2, 'Modify' = 3, 'Rename' = 4, 'Copy' = 5, 'Type' = 6),

path LowCardinality(String),

old_path LowCardinality(String),

file_extension LowCardinality(String),

lines_added UInt32,

lines_deleted UInt32,

hunks_added UInt32,

hunks_removed UInt32,

hunks_changed UInt32,

commit_hash String,

author LowCardinality(String),

time DateTime,

commit_message String,

commit_files_added UInt32,

commit_files_deleted UInt32,

commit_files_renamed UInt32,

commit_files_modified UInt32,

commit_lines_added UInt32,

commit_lines_deleted UInt32,

commit_hunks_added UInt32,

commit_hunks_removed UInt32,

commit_hunks_changed UInt32

) ENGINE = MergeTree ORDER BY time;

CREATE TABLE git.line_changes

(

sign Int8,

line_number_old UInt32,

line_number_new UInt32,

hunk_num UInt32,

hunk_start_line_number_old UInt32,

hunk_start_line_number_new UInt32,

hunk_lines_added UInt32,

hunk_lines_deleted UInt32,

hunk_context LowCardinality(String),

line LowCardinality(String),

indent UInt8,

line_type Enum('Empty' = 0, 'Comment' = 1, 'Punct' = 2, 'Code' = 3),

prev_commit_hash String,

prev_author LowCardinality(String),

prev_time DateTime,

file_change_type Enum('Add' = 1, 'Delete' = 2, 'Modify' = 3, 'Rename' = 4, 'Copy' = 5, 'Type' = 6),

path LowCardinality(String),

old_path LowCardinality(String),

file_extension LowCardinality(String),

file_lines_added UInt32,

file_lines_deleted UInt32,

file_hunks_added UInt32,

file_hunks_removed UInt32,

file_hunks_changed UInt32,

commit_hash String,

author LowCardinality(String),

time DateTime,

commit_message String,

commit_files_added UInt32,

commit_files_deleted UInt32,

commit_files_renamed UInt32,

commit_files_modified UInt32,

commit_lines_added UInt32,

commit_lines_deleted UInt32,

commit_hunks_added UInt32,

commit_hunks_removed UInt32,

commit_hunks_changed UInt32

) ENGINE = MergeTree ORDER BY time;

INSERT INTO SELECT と s3 function を使用してデータを挿入します。例えば、以下では ClickHouse のファイル群をそれぞれ対応するテーブルに挿入します。

commits

INSERT INTO git.commits SELECT *

FROM s3('https://datasets-documentation.s3.amazonaws.com/github/commits/clickhouse/commits.tsv.xz', 'TSV', 'hash String,author LowCardinality(String), time DateTime, message String, files_added UInt32, files_deleted UInt32, files_renamed UInt32, files_modified UInt32, lines_added UInt32, lines_deleted UInt32, hunks_added UInt32, hunks_removed UInt32, hunks_changed UInt32')

0 rows in set. Elapsed: 1.826 sec. Processed 62.78 thousand rows, 8.50 MB (34.39 thousand rows/s., 4.66 MB/s.)

file_changes

INSERT INTO git.file_changes SELECT *

FROM s3('https://datasets-documentation.s3.amazonaws.com/github/commits/clickhouse/file_changes.tsv.xz', 'TSV', 'change_type Enum(\'Add\' = 1, \'Delete\' = 2, \'Modify\' = 3, \'Rename\' = 4, \'Copy\' = 5, \'Type\' = 6), path LowCardinality(String), old_path LowCardinality(String), file_extension LowCardinality(String), lines_added UInt32, lines_deleted UInt32, hunks_added UInt32, hunks_removed UInt32, hunks_changed UInt32, commit_hash String, author LowCardinality(String), time DateTime, commit_message String, commit_files_added UInt32, commit_files_deleted UInt32, commit_files_renamed UInt32, commit_files_modified UInt32, commit_lines_added UInt32, commit_lines_deleted UInt32, commit_hunks_added UInt32, commit_hunks_removed UInt32, commit_hunks_changed UInt32')

0 rows in set. Elapsed: 2.688 sec. Processed 266.05 thousand rows, 48.30 MB (98.97 thousand rows/s., 17.97 MB/s.)

line_changes

INSERT INTO git.line_changes SELECT *

FROM s3('https://datasets-documentation.s3.amazonaws.com/github/commits/clickhouse/line_changes.tsv.xz', 'TSV', ' sign Int8, line_number_old UInt32, line_number_new UInt32, hunk_num UInt32, hunk_start_line_number_old UInt32, hunk_start_line_number_new UInt32, hunk_lines_added UInt32,\n hunk_lines_deleted UInt32, hunk_context LowCardinality(String), line LowCardinality(String), indent UInt8, line_type Enum(\'Empty\' = 0, \'Comment\' = 1, \'Punct\' = 2, \'Code\' = 3), prev_commit_hash String, prev_author LowCardinality(String), prev_time DateTime, file_change_type Enum(\'Add\' = 1, \'Delete\' = 2, \'Modify\' = 3, \'Rename\' = 4, \'Copy\' = 5, \'Type\' = 6),\n path LowCardinality(String), old_path LowCardinality(String), file_extension LowCardinality(String), file_lines_added UInt32, file_lines_deleted UInt32, file_hunks_added UInt32, file_hunks_removed UInt32, file_hunks_changed UInt32, commit_hash String,\n author LowCardinality(String), time DateTime, commit_message String, commit_files_added UInt32, commit_files_deleted UInt32, commit_files_renamed UInt32, commit_files_modified UInt32, commit_lines_added UInt32, commit_lines_deleted UInt32, commit_hunks_added UInt32, commit_hunks_removed UInt32, commit_hunks_changed UInt32')

0 rows in set. Elapsed: 50.535 sec. Processed 7.54 million rows, 2.09 GB (149.11 thousand rows/s., 41.40 MB/s.)

クエリ

このツールは、ヘルプ出力を通じていくつかのクエリ例を提示します。本セクションでは、それらに対する解説に加え、関連する補足的な問いにも対応します。ここで扱うクエリは、ツールが出力する任意の順序とは異なり、おおよそ簡単なものから複雑なものへと並べています。

このデータセットは、git_clickhouse データベースとして play.clickhouse.com で利用可能です。以降のすべてのクエリについて、この環境へのリンクを提示し、必要に応じてデータベース名を調整しています。なお、データ収集時期の違いにより、play 環境での実行結果は、ここに示す結果と異なる場合があります。

単一ファイルの履歴

最も単純なクエリです。ここでは StorageReplicatedMergeTree.cpp ファイルに対するすべてのコミットメッセージを取得します。これらの方が一般に興味深いため、最新のメッセージが先に来るようにソートします。

SELECT

time,

substring(commit_hash, 1, 11) AS commit,

change_type,

author,

path,

old_path,

lines_added,

lines_deleted,

commit_message

FROM git.file_changes

WHERE path = 'src/Storages/StorageReplicatedMergeTree.cpp'

ORDER BY time DESC

LIMIT 10

┌────────────────time─┬─commit──────┬─change_type─┬─author─────────────┬─path────────────────────────────────────────┬─old_path─┬─lines_added─┬─lines_deleted─┬─commit_message───────────────────────────────────┐

│ 2022-10-30 16:30:51 │ c68ab231f91 │ Modify │ Alexander Tokmakov │ src/Storages/StorageReplicatedMergeTree.cpp │ │ 13 │ 10 │ fix accessing part in Deleting state │

│ 2022-10-23 16:24:20 │ b40d9200d20 │ Modify │ Anton Popov │ src/Storages/StorageReplicatedMergeTree.cpp │ │ 28 │ 30 │ better semantic of constsness of DataPartStorage │

│ 2022-10-23 01:23:15 │ 56e5daba0c9 │ Modify │ Anton Popov │ src/Storages/StorageReplicatedMergeTree.cpp │ │ 28 │ 44 │ remove DataPartStorageBuilder │

│ 2022-10-21 13:35:37 │ 851f556d65a │ Modify │ Igor Nikonov │ src/Storages/StorageReplicatedMergeTree.cpp │ │ 3 │ 2 │ Remove unused parameter │

│ 2022-10-21 13:02:52 │ 13d31eefbc3 │ Modify │ Igor Nikonov │ src/Storages/StorageReplicatedMergeTree.cpp │ │ 4 │ 4 │ Replicated merge tree polishing │

│ 2022-10-21 12:25:19 │ 4e76629aafc │ Modify │ Azat Khuzhin │ src/Storages/StorageReplicatedMergeTree.cpp │ │ 3 │ 2 │ Fixes for -Wshorten-64-to-32 │

│ 2022-10-19 13:59:28 │ 05e6b94b541 │ Modify │ Antonio Andelic │ src/Storages/StorageReplicatedMergeTree.cpp │ │ 4 │ 0 │ Polishing │

│ 2022-10-19 13:34:20 │ e5408aac991 │ Modify │ Antonio Andelic │ src/Storages/StorageReplicatedMergeTree.cpp │ │ 3 │ 53 │ Simplify logic │

│ 2022-10-18 15:36:11 │ 7befe2825c9 │ Modify │ Alexey Milovidov │ src/Storages/StorageReplicatedMergeTree.cpp │ │ 2 │ 2 │ Update StorageReplicatedMergeTree.cpp │

│ 2022-10-18 15:35:44 │ 0623ad4e374 │ Modify │ Alexey Milovidov │ src/Storages/StorageReplicatedMergeTree.cpp │ │ 1 │ 1 │ Update StorageReplicatedMergeTree.cpp │

└─────────────────────┴─────────────┴─────────────┴────────────────────┴─────────────────────────────────────────────┴──────────┴─────────────┴───────────────┴──────────────────────────────────────────────────┘

10 rows in set. Elapsed: 0.006 sec. Processed 12.10 thousand rows, 1.60 MB (1.93 million rows/s., 255.40 MB/s.)

リネームを除外して、行ごとの変更も確認できます。つまり、ファイルが別の名前で存在していたリネーム前の変更は表示しません。

SELECT

time,

substring(commit_hash, 1, 11) AS commit,

sign,

line_number_old,

line_number_new,

author,

line

FROM git.line_changes

WHERE path = 'src/Storages/StorageReplicatedMergeTree.cpp'

ORDER BY line_number_new ASC

LIMIT 10

┌────────────────time─┬─commit──────┬─sign─┬─line_number_old─┬─line_number_new─┬─author───────────┬─line──────────────────────────────────────────────────┐

│ 2020-04-16 02:06:10 │ cdeda4ab915 │ -1 │ 1 │ 1 │ Alexey Milovidov │ #include <Disks/DiskSpaceMonitor.h> │

│ 2020-04-16 02:06:10 │ cdeda4ab915 │ 1 │ 2 │ 1 │ Alexey Milovidov │ #include <Core/Defines.h> │

│ 2020-04-16 02:06:10 │ cdeda4ab915 │ 1 │ 2 │ 2 │ Alexey Milovidov │ │

│ 2021-05-03 23:46:51 │ 02ce9cc7254 │ -1 │ 3 │ 2 │ Alexey Milovidov │ #include <Common/FieldVisitors.h> │

│ 2021-05-27 22:21:02 │ e2f29b9df02 │ -1 │ 3 │ 2 │ s-kat │ #include <Common/FieldVisitors.h> │

│ 2022-10-03 22:30:50 │ 210882b9c4d │ 1 │ 2 │ 3 │ alesapin │ #include <ranges> │

│ 2022-10-23 16:24:20 │ b40d9200d20 │ 1 │ 2 │ 3 │ Anton Popov │ #include <cstddef> │

│ 2021-06-20 09:24:43 │ 4c391f8e994 │ 1 │ 2 │ 3 │ Mike Kot │ #include "Common/hex.h" │

│ 2021-12-29 09:18:56 │ 8112a712336 │ -1 │ 6 │ 5 │ avogar │ #include <Common/ThreadPool.h> │

│ 2022-04-21 20:19:13 │ 9133e398b8c │ 1 │ 11 │ 12 │ Nikolai Kochetov │ #include <Storages/MergeTree/DataPartStorageOnDisk.h> │

└─────────────────────┴─────────────┴──────┴─────────────────┴─────────────────┴──────────────────┴───────────────────────────────────────────────────────┘

10 rows in set. Elapsed: 0.258 sec. Processed 7.54 million rows, 654.92 MB (29.24 million rows/s., 2.54 GB/s.)

なお、ファイルの行ごとのコミット履歴をリネームも考慮して取得する、より複雑なクエリのバリエーションもあります。

現在アクティブなファイルを特定する

これは、リポジトリ内の現在のファイルだけを対象にしたい後続の分析において重要になります。ここでは、名前変更や削除(およびその後の再追加/再命名)が行われていないファイルを、現在のファイル群として推定します。

dbms、libs、tests/testflows/ ディレクトリ配下のファイルの名前変更に関連して、コミット履歴が壊れているように見える箇所があります。そのため、これらも除外します。

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)') ORDER BY path

LIMIT 10

┌─path────────────────────────────────────────────────────────────┐

│ tests/queries/0_stateless/01054_random_printable_ascii_ubsan.sh │

│ tests/queries/0_stateless/02247_read_bools_as_numbers_json.sh │

│ tests/performance/file_table_function.xml │

│ tests/queries/0_stateless/01902_self_aliases_in_columns.sql │

│ tests/queries/0_stateless/01070_h3_get_base_cell.reference │

│ src/Functions/ztest.cpp │

│ src/Interpreters/InterpreterShowTablesQuery.h │

│ src/Parsers/Kusto/ParserKQLStatement.h │

│ tests/queries/0_stateless/00938_dataset_test.sql │

│ src/Dictionaries/Embedded/GeodataProviders/Types.h │

└─────────────────────────────────────────────────────────────────┘

10 rows in set. Elapsed: 0.085 sec. Processed 532.10 thousand rows, 8.68 MB (6.30 million rows/s., 102.64 MB/s.)

ここでは、ファイル名を変更した後に、再度元の名前に戻すことも可能にしている点に注意してください。まず、リネームの結果として削除されたファイルの一覧について old_path を集約します。次に、その結果を各 path に対する最後の操作と UNION します。最後に、最終イベントが Delete ではないものだけにこの一覧を絞り込みます。

SELECT uniq(path)

FROM

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)') ORDER BY path

)

┌─uniq(path)─┐

│ 18559 │

└────────────┘

1 row in set. Elapsed: 0.089 sec. Processed 532.10 thousand rows, 8.68 MB (6.01 million rows/s., 97.99 MB/s.)

インポート時には、いくつかのディレクトリをスキップしている点に注意してください。例えば次のようになります。

--skip-paths 'generated\.cpp|^(contrib|docs?|website|libs/(libcityhash|liblz4|libdivide|libvectorclass|libdouble-conversion|libcpuid|libzstd|libfarmhash|libmetrohash|libpoco|libwidechar_width))/'

このパターンを git list-files に適用すると、18155 件のファイルが報告されます。

git ls-files | grep -v -E 'generated\.cpp|^(contrib|docs?|website|libs/(libcityhash|liblz4|libdivide|libvectorclass|libdouble-conversion|libcpuid|libzstd|libfarmhash|libmetrohash|libpoco|libwidechar_width))/' | wc -l

18155

したがって、ここで用いているソリューションは、現在のファイルを推定したものにすぎません

この差異が生じる理由はいくつかあります。

- ファイルのリネームは、そのファイルに対する他の変更と同時に発生することがあります。これらは

file_changesでは同じ時刻を持つ別個のイベントとして記録されます。argMax関数にはこれらを区別する手段がないため、最初の値を選択します。インサートの自然な順序(正しい順序を知る唯一の手がかり)はUNIONをまたいでは維持されないため、Modify イベントが選択されてしまう可能性があります。たとえば、下記の例ではsrc/Functions/geometryFromColumn.hファイルはsrc/Functions/geometryConverters.hにリネームされる前に複数回変更されています。現在の方式では、最新の変更として Modify イベントが選ばれ、その結果src/Functions/geometryFromColumn.hが保持されてしまう場合があります。

SELECT

change_type,

path,

old_path,

time,

commit_hash

FROM git.file_changes

WHERE (path = 'src/Functions/geometryFromColumn.h') OR (old_path = 'src/Functions/geometryFromColumn.h')

┌─change_type─┬─path───────────────────────────────┬─old_path───────────────────────────┬────────────────time─┬─commit_hash──────────────────────────────┐

│ Add │ src/Functions/geometryFromColumn.h │ │ 2021-03-11 12:08:16 │ 9376b676e9a9bb8911b872e1887da85a45f7479d │

│ Modify │ src/Functions/geometryFromColumn.h │ │ 2021-03-11 12:08:16 │ 6d59be5ea4768034f6526f7f9813062e0c369f7b │

│ Modify │ src/Functions/geometryFromColumn.h │ │ 2021-03-11 12:08:16 │ 33acc2aa5dc091a7cb948f78c558529789b2bad8 │

│ Modify │ src/Functions/geometryFromColumn.h │ │ 2021-03-11 12:08:16 │ 78e0db268ceadc42f82bc63a77ee1a4da6002463 │

│ Modify │ src/Functions/geometryFromColumn.h │ │ 2021-03-11 12:08:16 │ 14a891057d292a164c4179bfddaef45a74eaf83a │

│ Modify │ src/Functions/geometryFromColumn.h │ │ 2021-03-11 12:08:16 │ d0d6e6953c2a2af9fb2300921ff96b9362f22edb │

│ Modify │ src/Functions/geometryFromColumn.h │ │ 2021-03-11 12:08:16 │ fe8382521139a58c0ba277eb848e88894658db66 │

│ Modify │ src/Functions/geometryFromColumn.h │ │ 2021-03-11 12:08:16 │ 3be3d5cde8788165bc0558f1e2a22568311c3103 │

│ Modify │ src/Functions/geometryFromColumn.h │ │ 2021-03-11 12:08:16 │ afad9bf4d0a55ed52a3f55483bc0973456e10a56 │

│ Modify │ src/Functions/geometryFromColumn.h │ │ 2021-03-11 12:08:16 │ e3290ecc78ca3ea82b49ebcda22b5d3a4df154e6 │

│ Rename │ src/Functions/geometryConverters.h │ src/Functions/geometryFromColumn.h │ 2021-03-11 12:08:16 │ 125945769586baf6ffd15919b29565b1b2a63218 │

└─────────────┴────────────────────────────────────┴────────────────────────────────────┴─────────────────────┴──────────────────────────────────────────┘

11 rows in set. Elapsed: 0.030 sec. Processed 266.05 thousand rows, 6.61 MB (8.89 million rows/s., 220.82 MB/s.)

- コミット履歴に破損があり、削除イベントが欠落しています。原因および発生元は未解明です。

これらの差分は、本分析に大きな影響を与えるものではありません。このクエリの改良版のご提供を歓迎します。

変更回数が最も多いファイルを一覧表示する

現在のファイルのみに対象を絞り、削除と追加の合計を変更回数として扱います。

WITH current_files AS

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND (NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)'))

ORDER BY path ASC

)

SELECT

path,

sum(lines_added) + sum(lines_deleted) AS modifications

FROM git.file_changes

WHERE (path IN (current_files)) AND (file_extension IN ('h', 'cpp', 'sql'))

GROUP BY path

ORDER BY modifications DESC

LIMIT 10

┌─path───────────────────────────────────────────────────┬─modifications─┐

│ src/Storages/StorageReplicatedMergeTree.cpp │ 21871 │

│ src/Storages/MergeTree/MergeTreeData.cpp │ 17709 │

│ programs/client/Client.cpp │ 15882 │

│ src/Storages/MergeTree/MergeTreeDataSelectExecutor.cpp │ 14249 │

│ src/Interpreters/InterpreterSelectQuery.cpp │ 12636 │

│ src/Parsers/ExpressionListParsers.cpp │ 11794 │

│ src/Analyzer/QueryAnalysisPass.cpp │ 11760 │

│ src/Coordination/KeeperStorage.cpp │ 10225 │

│ src/Functions/FunctionsConversion.h │ 9247 │

│ src/Parsers/ExpressionElementParsers.cpp │ 8197 │

└────────────────────────────────────────────────────────┴───────────────┘

10 rows in set. Elapsed: 0.134 sec. Processed 798.15 thousand rows, 16.46 MB (5.95 million rows/s., 122.62 MB/s.)

コミットは通常、週のどの曜日に行われていますか?

SELECT

day_of_week,

count() AS c

FROM git.commits

GROUP BY dayOfWeek(time) AS day_of_week

┌─day_of_week─┬─────c─┐

│ 1 │ 10575 │

│ 2 │ 10645 │

│ 3 │ 10748 │

│ 4 │ 10944 │

│ 5 │ 10090 │

│ 6 │ 4617 │

│ 7 │ 5166 │

└─────────────┴───────┘

7 rows in set. Elapsed: 0.262 sec. Processed 62.78 thousand rows, 251.14 KB (239.73 thousand rows/s., 958.93 KB/s.)

金曜日に少し生産性が落ちているのも自然ですね。週末にもコードをコミットしてくれているのは素晴らしいことです!コントリビューターの皆さんに心から感謝します!

サブディレクトリ/ファイルの履歴 - 行数、コミット数、コントリビューター数の時系列推移

フィルタリングしない場合、クエリ結果が非常に大きくなり、表示や可視化が現実的ではありません。そのため、次の例ではファイルまたはサブディレクトリでフィルタリングできるようにしています。ここでは toStartOfWeek 関数を使って週単位でグループ化していますが、必要に応じて変更してください。

SELECT

week,

sum(lines_added) AS lines_added,

sum(lines_deleted) AS lines_deleted,

uniq(commit_hash) AS num_commits,

uniq(author) AS authors

FROM git.file_changes

WHERE path LIKE 'src/Storages%'

GROUP BY toStartOfWeek(time) AS week

ORDER BY week ASC

LIMIT 10

┌───────week─┬─lines_added─┬─lines_deleted─┬─num_commits─┬─authors─┐

│ 2020-03-29 │ 49 │ 35 │ 4 │ 3 │

│ 2020-04-05 │ 940 │ 601 │ 55 │ 14 │

│ 2020-04-12 │ 1472 │ 607 │ 32 │ 11 │

│ 2020-04-19 │ 917 │ 841 │ 39 │ 12 │

│ 2020-04-26 │ 1067 │ 626 │ 36 │ 10 │

│ 2020-05-03 │ 514 │ 435 │ 27 │ 10 │

│ 2020-05-10 │ 2552 │ 537 │ 48 │ 12 │

│ 2020-05-17 │ 3585 │ 1913 │ 83 │ 9 │

│ 2020-05-24 │ 2851 │ 1812 │ 74 │ 18 │

│ 2020-05-31 │ 2771 │ 2077 │ 77 │ 16 │

└────────────┴─────────────┴───────────────┴─────────────┴─────────┘

10 rows in set. Elapsed: 0.043 sec. Processed 266.05 thousand rows, 15.85 MB (6.12 million rows/s., 364.61 MB/s.)

このデータは可視化に向いています。以下では Superset を使用します。

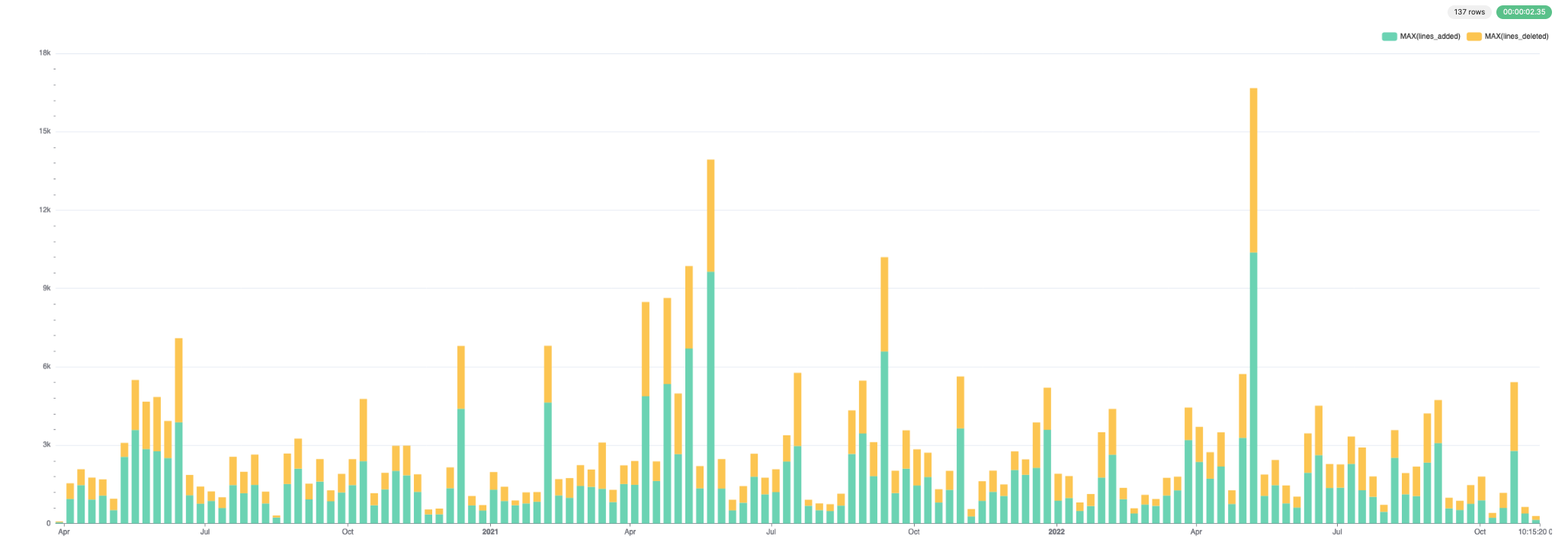

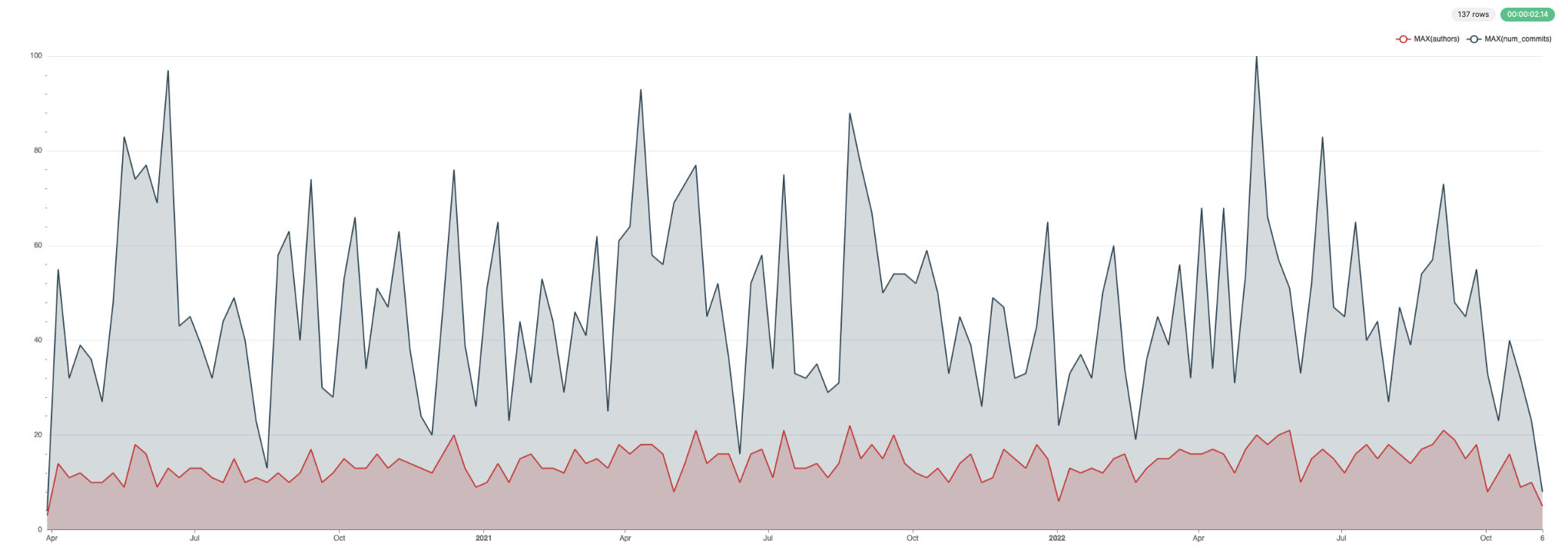

追加・削除された行数:

コミット数と著者:

著者数が最も多いファイルを一覧表示

現在存在するファイルのみに限定します。

WITH current_files AS

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND (NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)'))

ORDER BY path ASC

)

SELECT

path,

uniq(author) AS num_authors

FROM git.file_changes

WHERE path IN (current_files)

GROUP BY path

ORDER BY num_authors DESC

LIMIT 10

┌─path────────────────────────────────────────┬─num_authors─┐

│ src/Core/Settings.h │ 127 │

│ CMakeLists.txt │ 96 │

│ .gitmodules │ 85 │

│ src/Storages/MergeTree/MergeTreeData.cpp │ 72 │

│ src/CMakeLists.txt │ 71 │

│ programs/server/Server.cpp │ 70 │

│ src/Interpreters/Context.cpp │ 64 │

│ src/Storages/StorageReplicatedMergeTree.cpp │ 63 │

│ src/Common/ErrorCodes.cpp │ 61 │

│ src/Interpreters/InterpreterSelectQuery.cpp │ 59 │

└─────────────────────────────────────────────┴─────────────┘

10 rows in set. Elapsed: 0.239 sec. Processed 798.15 thousand rows, 14.13 MB (3.35 million rows/s., 59.22 MB/s.)

リポジトリ内で最も古いコード行

現在存在するファイルのみを対象とします。

WITH current_files AS

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND (NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)'))

ORDER BY path ASC

)

SELECT

any(path) AS file_path,

line,

max(time) AS latest_change,

any(file_change_type)

FROM git.line_changes

WHERE path IN (current_files)

GROUP BY line

ORDER BY latest_change ASC

LIMIT 10

┌─file_path───────────────────────────────────┬─line────────────────────────────────────────────────────────┬───────latest_change─┬─any(file_change_type)─┐

│ utils/compressor/test.sh │ ./compressor -d < compressor.snp > compressor2 │ 2011-06-17 22:19:39 │ Modify │

│ utils/compressor/test.sh │ ./compressor < compressor > compressor.snp │ 2011-06-17 22:19:39 │ Modify │

│ utils/compressor/test.sh │ ./compressor -d < compressor.qlz > compressor2 │ 2014-02-24 03:14:30 │ Add │

│ utils/compressor/test.sh │ ./compressor < compressor > compressor.qlz │ 2014-02-24 03:14:30 │ Add │

│ utils/config-processor/config-processor.cpp │ if (argc != 2) │ 2014-02-26 19:10:00 │ Add │

│ utils/config-processor/config-processor.cpp │ std::cerr << "std::exception: " << e.what() << std::endl; │ 2014-02-26 19:10:00 │ Add │

│ utils/config-processor/config-processor.cpp │ std::cerr << "Exception: " << e.displayText() << std::endl; │ 2014-02-26 19:10:00 │ Add │

│ utils/config-processor/config-processor.cpp │ Poco::XML::DOMWriter().writeNode(std::cout, document); │ 2014-02-26 19:10:00 │ Add │

│ utils/config-processor/config-processor.cpp │ std::cerr << "Some exception" << std::endl; │ 2014-02-26 19:10:00 │ Add │

│ utils/config-processor/config-processor.cpp │ std::cerr << "usage: " << argv[0] << " path" << std::endl; │ 2014-02-26 19:10:00 │ Add │

└─────────────────────────────────────────────┴─────────────────────────────────────────────────────────────┴─────────────────────┴───────────────────────┘

10 rows in set. Elapsed: 1.101 sec. Processed 8.07 million rows, 905.86 MB (7.33 million rows/s., 823.13 MB/s.)

履歴が最も長いファイル

現在存在するファイルのみが対象です。

WITH current_files AS

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND (NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)'))

ORDER BY path ASC

)

SELECT

count() AS c,

path,

max(time) AS latest_change

FROM git.file_changes

WHERE path IN (current_files)

GROUP BY path

ORDER BY c DESC

LIMIT 10

┌───c─┬─path────────────────────────────────────────┬───────latest_change─┐

│ 790 │ src/Storages/StorageReplicatedMergeTree.cpp │ 2022-10-30 16:30:51 │

│ 788 │ src/Storages/MergeTree/MergeTreeData.cpp │ 2022-11-04 09:26:44 │

│ 752 │ src/Core/Settings.h │ 2022-10-25 11:35:25 │

│ 749 │ CMakeLists.txt │ 2022-10-05 21:00:49 │

│ 575 │ src/Interpreters/InterpreterSelectQuery.cpp │ 2022-11-01 10:20:10 │

│ 563 │ CHANGELOG.md │ 2022-10-27 08:19:50 │

│ 491 │ src/Interpreters/Context.cpp │ 2022-10-25 12:26:29 │

│ 437 │ programs/server/Server.cpp │ 2022-10-21 12:25:19 │

│ 375 │ programs/client/Client.cpp │ 2022-11-03 03:16:55 │

│ 350 │ src/CMakeLists.txt │ 2022-10-24 09:22:37 │

└─────┴─────────────────────────────────────────────┴─────────────────────┘

10 rows in set. Elapsed: 0.124 sec. Processed 798.15 thousand rows, 14.71 MB (6.44 million rows/s., 118.61 MB/s.)

私たちのコアデータ構造である Merge Tree は、長年にわたって数多くの変更が加えられており、今も絶えず進化し続けています。

今月におけるドキュメントとコード別のコントリビューター分布

データ取得時、docs/ フォルダーにはコミット履歴が非常に入り組んでいたため、その変更は除外されています。そのため、このクエリの結果は正確ではありません。

月の特定のタイミング、たとえばリリース時期などにドキュメントを多く執筆しているのでしょうか?countIf 関数を使って単純な比率を計算し、その結果を bar 関数で可視化できます。

SELECT

day,

bar(docs_ratio * 1000, 0, 100, 100) AS bar

FROM

(

SELECT

day,

countIf(file_extension IN ('h', 'cpp', 'sql')) AS code,

countIf(file_extension = 'md') AS docs,

docs / (code + docs) AS docs_ratio

FROM git.line_changes

WHERE (sign = 1) AND (file_extension IN ('h', 'cpp', 'sql', 'md'))

GROUP BY dayOfMonth(time) AS day

)

┌─day─┬─bar─────────────────────────────────────────────────────────────┐

│ 1 │ ███████████████████████████████████▍ │

│ 2 │ ███████████████████████▋ │

│ 3 │ ████████████████████████████████▋ │

│ 4 │ █████████████ │

│ 5 │ █████████████████████▎ │

│ 6 │ ████████ │

│ 7 │ ███▋ │

│ 8 │ ████████▌ │

│ 9 │ ██████████████▎ │

│ 10 │ █████████████████▏ │

│ 11 │ █████████████▎ │

│ 12 │ ███████████████████████████████████▋ │

│ 13 │ █████████████████████████████▎ │

│ 14 │ ██████▋ │

│ 15 │ █████████████████████████████████████████▊ │

│ 16 │ ██████████▎ │

│ 17 │ ██████████████████████████████████████▋ │

│ 18 │ █████████████████████████████████▌ │

│ 19 │ ███████████ │

│ 20 │ █████████████████████████████████▊ │

│ 21 │ █████ │

│ 22 │ ███████████████████████▋ │

│ 23 │ ███████████████████████████▌ │

│ 24 │ ███████▌ │

│ 25 │ ██████████████████████████████████▎ │

│ 26 │ ███████████▏ │

│ 27 │ ███████████████████████████████████████████████████████████████ │

│ 28 │ ████████████████████████████████████████████████████▏ │

│ 29 │ ███▌ │

│ 30 │ ████████████████████████████████████████▎ │

│ 31 │ █████████████████████████████████▏ │

└─────┴─────────────────────────────────────────────────────────────────┘

31 rows in set. Elapsed: 0.043 sec. Processed 7.54 million rows, 40.53 MB (176.71 million rows/s., 950.40 MB/s.)

月末近くに少し多くなる傾向はありますが、全体としては概ね良好に均等分布しています。繰り返しになりますが、データ挿入時に適用される docs フィルターによる絞り込みの影響で、この数値の信頼性はあまり高くありません。

最も幅広く影響を与えている著者

ここでの「多様性」とは、著者が貢献したユニークなファイルの数を指します。

SELECT

author,

uniq(path) AS num_files

FROM git.file_changes

WHERE (change_type IN ('Add', 'Modify')) AND (file_extension IN ('h', 'cpp', 'sql'))

GROUP BY author

ORDER BY num_files DESC

LIMIT 10

┌─author─────────────┬─num_files─┐

│ Alexey Milovidov │ 8433 │

│ Nikolai Kochetov │ 3257 │

│ Vitaly Baranov │ 2316 │

│ Maksim Kita │ 2172 │

│ Azat Khuzhin │ 1988 │

│ alesapin │ 1818 │

│ Alexander Tokmakov │ 1751 │

│ Amos Bird │ 1641 │

│ Ivan │ 1629 │

│ alexey-milovidov │ 1581 │

└────────────────────┴───────────┘

10 rows in set. Elapsed: 0.041 sec. Processed 266.05 thousand rows, 4.92 MB (6.56 million rows/s., 121.21 MB/s.)

直近の作業において、誰のコミットが最も多様であるかを見てみましょう。日付で絞り込むのではなく、ある作者の直近 N 件のコミットに限定します(ここでは 3 件としていますが、自由に変更できます):

SELECT

author,

sum(num_files_commit) AS num_files

FROM

(

SELECT

author,

commit_hash,

uniq(path) AS num_files_commit,

max(time) AS commit_time

FROM git.file_changes

WHERE (change_type IN ('Add', 'Modify')) AND (file_extension IN ('h', 'cpp', 'sql'))

GROUP BY

author,

commit_hash

ORDER BY

author ASC,

commit_time DESC

LIMIT 3 BY author

)

GROUP BY author

ORDER BY num_files DESC

LIMIT 10

┌─author───────────────┬─num_files─┐

│ Mikhail │ 782 │

│ Li Yin │ 553 │

│ Roman Peshkurov │ 119 │

│ Vladimir Smirnov │ 88 │

│ f1yegor │ 65 │

│ maiha │ 54 │

│ Vitaliy Lyudvichenko │ 53 │

│ Pradeep Chhetri │ 40 │

│ Orivej Desh │ 38 │

│ liyang │ 36 │

└──────────────────────┴───────────┘

10 rows in set. Elapsed: 0.106 sec. Processed 266.05 thousand rows, 21.04 MB (2.52 million rows/s., 198.93 MB/s.)

ある著者のお気に入りファイル

ここでは創業者である Alexey Milovidov を選択し、分析対象を現行のファイルに限定します。

WITH current_files AS

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND (NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)'))

ORDER BY path ASC

)

SELECT

path,

count() AS c

FROM git.file_changes

WHERE (author = 'Alexey Milovidov') AND (path IN (current_files))

GROUP BY path

ORDER BY c DESC

LIMIT 10

┌─path────────────────────────────────────────┬───c─┐

│ CMakeLists.txt │ 165 │

│ CHANGELOG.md │ 126 │

│ programs/server/Server.cpp │ 73 │

│ src/Storages/MergeTree/MergeTreeData.cpp │ 71 │

│ src/Storages/StorageReplicatedMergeTree.cpp │ 68 │

│ src/Core/Settings.h │ 65 │

│ programs/client/Client.cpp │ 57 │

│ programs/server/play.html │ 48 │

│ .gitmodules │ 47 │

│ programs/install/Install.cpp │ 37 │

└─────────────────────────────────────────────┴─────┘

10 rows in set. Elapsed: 0.106 sec. Processed 798.15 thousand rows, 13.97 MB (7.51 million rows/s., 131.41 MB/s.)

これは、Alexey が Change log の保守を担当してきたため、もっともです。では、彼のよく利用されているファイルを特定するために、ファイルのベース名を使うのはどうでしょうか。こうすることでリネームにも対応でき、コードへの貢献に注目できるはずです。

SELECT

base,

count() AS c

FROM git.file_changes

WHERE (author = 'Alexey Milovidov') AND (file_extension IN ('h', 'cpp', 'sql'))

GROUP BY basename(path) AS base

ORDER BY c DESC

LIMIT 10

┌─base───────────────────────────┬───c─┐

│ StorageReplicatedMergeTree.cpp │ 393 │

│ InterpreterSelectQuery.cpp │ 299 │

│ Aggregator.cpp │ 297 │

│ Client.cpp │ 280 │

│ MergeTreeData.cpp │ 274 │

│ Server.cpp │ 264 │

│ ExpressionAnalyzer.cpp │ 259 │

│ StorageMergeTree.cpp │ 239 │

│ Settings.h │ 225 │

│ TCPHandler.cpp │ 205 │

└────────────────────────────────┴─────┘

10 rows in set. Elapsed: 0.032 sec. Processed 266.05 thousand rows, 5.68 MB (8.22 million rows/s., 175.50 MB/s.)

こちらのほうが、彼の関心分野をよりよく反映しているかもしれません。

著者数が少ない最大のファイル

このためには、まず最大のファイルを特定する必要があります。すべてのコミット履歴から、すべてのファイルについて完全なファイル再構築を行って推定するのは、計算コストが非常に高くなります。

そこで、推定では現存するファイルのみに対象を絞り、追加された行数の合計から削除された行数を差し引きます。こうして得られたファイルの長さと著者数の比率を計算します。

WITH current_files AS

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND (NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)'))

ORDER BY path ASC

)

SELECT

path,

sum(lines_added) - sum(lines_deleted) AS num_lines,

uniqExact(author) AS num_authors,

num_lines / num_authors AS lines_author_ratio

FROM git.file_changes

WHERE path IN (current_files)

GROUP BY path

ORDER BY lines_author_ratio DESC

LIMIT 10

┌─path──────────────────────────────────────────────────────────────────┬─num_lines─┬─num_authors─┬─lines_author_ratio─┐

│ src/Common/ClassificationDictionaries/emotional_dictionary_rus.txt │ 148590 │ 1 │ 148590 │

│ src/Functions/ClassificationDictionaries/emotional_dictionary_rus.txt │ 55533 │ 1 │ 55533 │

│ src/Functions/ClassificationDictionaries/charset_freq.txt │ 35722 │ 1 │ 35722 │

│ src/Common/ClassificationDictionaries/charset_freq.txt │ 35722 │ 1 │ 35722 │

│ tests/integration/test_storage_meilisearch/movies.json │ 19549 │ 1 │ 19549 │

│ tests/queries/0_stateless/02364_multiSearch_function_family.reference │ 12874 │ 1 │ 12874 │

│ src/Functions/ClassificationDictionaries/programming_freq.txt │ 9434 │ 1 │ 9434 │

│ src/Common/ClassificationDictionaries/programming_freq.txt │ 9434 │ 1 │ 9434 │

│ tests/performance/explain_ast.xml │ 5911 │ 1 │ 5911 │

│ src/Analyzer/QueryAnalysisPass.cpp │ 5686 │ 1 │ 5686 │

└───────────────────────────────────────────────────────────────────────┴───────────┴─────────────┴────────────────────┘

10 rows in set. Elapsed: 0.138 sec. Processed 798.15 thousand rows, 16.57 MB (5.79 million rows/s., 120.11 MB/s.)

テキスト辞書はあまり現実的ではなさそうなので、ファイル拡張子でフィルタしてコードのみに対象を絞りましょう。

WITH current_files AS

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND (NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)'))

ORDER BY path ASC

)

SELECT

path,

sum(lines_added) - sum(lines_deleted) AS num_lines,

uniqExact(author) AS num_authors,

num_lines / num_authors AS lines_author_ratio

FROM git.file_changes

WHERE (path IN (current_files)) AND (file_extension IN ('h', 'cpp', 'sql'))

GROUP BY path

ORDER BY lines_author_ratio DESC

LIMIT 10

┌─path──────────────────────────────────┬─num_lines─┬─num_authors─┬─lines_author_ratio─┐

│ src/Analyzer/QueryAnalysisPass.cpp │ 5686 │ 1 │ 5686 │

│ src/Analyzer/QueryTreeBuilder.cpp │ 880 │ 1 │ 880 │

│ src/Planner/Planner.cpp │ 873 │ 1 │ 873 │

│ src/Backups/RestorerFromBackup.cpp │ 869 │ 1 │ 869 │

│ utils/memcpy-bench/FastMemcpy.h │ 770 │ 1 │ 770 │

│ src/Planner/PlannerActionsVisitor.cpp │ 765 │ 1 │ 765 │

│ src/Functions/sphinxstemen.cpp │ 728 │ 1 │ 728 │

│ src/Planner/PlannerJoinTree.cpp │ 708 │ 1 │ 708 │

│ src/Planner/PlannerJoins.cpp │ 695 │ 1 │ 695 │

│ src/Analyzer/QueryNode.h │ 607 │ 1 │ 607 │

└───────────────────────────────────────┴───────────┴─────────────┴────────────────────┘

10 rows in set. Elapsed: 0.140 sec. Processed 798.15 thousand rows, 16.84 MB (5.70 million rows/s., 120.32 MB/s.)

ここには、ある種の「最近のものへのバイアス(recency bias)」があります。新しいファイルはコミットされる機会が少ないためです。では、少なくとも作成から 1 年以上経過したファイルに限定したらどうなるでしょうか?

WITH current_files AS

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND (NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)'))

ORDER BY path ASC

)

SELECT

min(time) AS min_date,

path,

sum(lines_added) - sum(lines_deleted) AS num_lines,

uniqExact(author) AS num_authors,

num_lines / num_authors AS lines_author_ratio

FROM git.file_changes

WHERE (path IN (current_files)) AND (file_extension IN ('h', 'cpp', 'sql'))

GROUP BY path

HAVING min_date <= (now() - toIntervalYear(1))

ORDER BY lines_author_ratio DESC

LIMIT 10

┌────────────min_date─┬─path───────────────────────────────────────────────────────────┬─num_lines─┬─num_authors─┬─lines_author_ratio─┐

│ 2021-03-08 07:00:54 │ utils/memcpy-bench/FastMemcpy.h │ 770 │ 1 │ 770 │

│ 2021-05-04 13:47:34 │ src/Functions/sphinxstemen.cpp │ 728 │ 1 │ 728 │

│ 2021-03-14 16:52:51 │ utils/memcpy-bench/glibc/dwarf2.h │ 592 │ 1 │ 592 │

│ 2021-03-08 09:04:52 │ utils/memcpy-bench/FastMemcpy_Avx.h │ 496 │ 1 │ 496 │

│ 2020-10-19 01:10:50 │ tests/queries/0_stateless/01518_nullable_aggregate_states2.sql │ 411 │ 1 │ 411 │

│ 2020-11-24 14:53:34 │ programs/server/GRPCHandler.cpp │ 399 │ 1 │ 399 │

│ 2021-03-09 14:10:28 │ src/DataTypes/Serializations/SerializationSparse.cpp │ 363 │ 1 │ 363 │

│ 2021-08-20 15:06:57 │ src/Functions/vectorFunctions.cpp │ 1327 │ 4 │ 331.75 │

│ 2020-08-04 03:26:23 │ src/Interpreters/MySQL/CreateQueryConvertVisitor.cpp │ 311 │ 1 │ 311 │

│ 2020-11-06 15:45:13 │ src/Storages/Rocksdb/StorageEmbeddedRocksdb.cpp │ 611 │ 2 │ 305.5 │

└─────────────────────┴────────────────────────────────────────────────────────────────┴───────────┴─────────────┴────────────────────┘

10 rows in set. Elapsed: 0.143 sec. Processed 798.15 thousand rows, 18.00 MB (5.58 million rows/s., 125.87 MB/s.)

時間別(曜日別、著者別、特定サブディレクトリ別)のコミット数とコード行数の分布

ここでは、曜日ごとの追加行数と削除行数として解釈します。この例では、Functions ディレクトリに注目します。

SELECT

dayOfWeek,

uniq(commit_hash) AS commits,

sum(lines_added) AS lines_added,

sum(lines_deleted) AS lines_deleted

FROM git.file_changes

WHERE path LIKE 'src/Functions%'

GROUP BY toDayOfWeek(time) AS dayOfWeek

┌─dayOfWeek─┬─commits─┬─lines_added─┬─lines_deleted─┐

│ 1 │ 476 │ 24619 │ 15782 │

│ 2 │ 434 │ 18098 │ 9938 │

│ 3 │ 496 │ 26562 │ 20883 │

│ 4 │ 587 │ 65674 │ 18862 │

│ 5 │ 504 │ 85917 │ 14518 │

│ 6 │ 314 │ 13604 │ 10144 │

│ 7 │ 294 │ 11938 │ 6451 │

└───────────┴─────────┴─────────────┴───────────────┘

7 rows in set. Elapsed: 0.034 sec. Processed 266.05 thousand rows, 14.66 MB (7.73 million rows/s., 425.56 MB/s.)

さらに、時間帯別では次のとおりです。

SELECT

hourOfDay,

uniq(commit_hash) AS commits,

sum(lines_added) AS lines_added,

sum(lines_deleted) AS lines_deleted

FROM git.file_changes

WHERE path LIKE 'src/Functions%'

GROUP BY toHour(time) AS hourOfDay

┌─hourOfDay─┬─commits─┬─lines_added─┬─lines_deleted─┐

│ 0 │ 71 │ 4169 │ 3404 │

│ 1 │ 90 │ 2174 │ 1927 │

│ 2 │ 65 │ 2343 │ 1515 │

│ 3 │ 76 │ 2552 │ 493 │

│ 4 │ 62 │ 1480 │ 1304 │

│ 5 │ 38 │ 1644 │ 253 │

│ 6 │ 104 │ 4434 │ 2979 │

│ 7 │ 117 │ 4171 │ 1678 │

│ 8 │ 106 │ 4604 │ 4673 │

│ 9 │ 135 │ 60550 │ 2678 │

│ 10 │ 149 │ 6133 │ 3482 │

│ 11 │ 182 │ 8040 │ 3833 │

│ 12 │ 209 │ 29428 │ 15040 │

│ 13 │ 187 │ 10204 │ 5491 │

│ 14 │ 204 │ 9028 │ 6060 │

│ 15 │ 231 │ 15179 │ 10077 │

│ 16 │ 196 │ 9568 │ 5925 │

│ 17 │ 138 │ 4941 │ 3849 │

│ 18 │ 123 │ 4193 │ 3036 │

│ 19 │ 165 │ 8817 │ 6646 │

│ 20 │ 140 │ 3749 │ 2379 │

│ 21 │ 132 │ 41585 │ 4182 │

│ 22 │ 85 │ 4094 │ 3955 │

│ 23 │ 100 │ 3332 │ 1719 │

└───────────┴─────────┴─────────────┴───────────────┘

24 rows in set. Elapsed: 0.039 sec. Processed 266.05 thousand rows, 14.66 MB (6.77 million rows/s., 372.89 MB/s.)

この分布は、開発チームの大半がアムステルダムに拠点を置いていることを考えると妥当です。bar 関数を使うと、こうした分布を可視化できます:

SELECT

hourOfDay,

bar(commits, 0, 400, 50) AS commits,

bar(lines_added, 0, 30000, 50) AS lines_added,

bar(lines_deleted, 0, 15000, 50) AS lines_deleted

FROM

(

SELECT

hourOfDay,

uniq(commit_hash) AS commits,

sum(lines_added) AS lines_added,

sum(lines_deleted) AS lines_deleted

FROM git.file_changes

WHERE path LIKE 'src/Functions%'

GROUP BY toHour(time) AS hourOfDay

)

┌─hourOfDay─┬─commits───────────────────────┬─lines_added────────────────────────────────────────┬─lines_deleted──────────────────────────────────────┐

│ 0 │ ████████▊ │ ██████▊ │ ███████████▎ │

│ 1 │ ███████████▎ │ ███▌ │ ██████▍ │

│ 2 │ ████████ │ ███▊ │ █████ │

│ 3 │ █████████▌ │ ████▎ │ █▋ │

│ 4 │ ███████▋ │ ██▍ │ ████▎ │

│ 5 │ ████▋ │ ██▋ │ ▋ │

│ 6 │ █████████████ │ ███████▍ │ █████████▊ │

│ 7 │ ██████████████▋ │ ██████▊ │ █████▌ │

│ 8 │ █████████████▎ │ ███████▋ │ ███████████████▌ │

│ 9 │ ████████████████▊ │ ██████████████████████████████████████████████████ │ ████████▊ │

│ 10 │ ██████████████████▋ │ ██████████▏ │ ███████████▌ │

│ 11 │ ██████████████████████▋ │ █████████████▍ │ ████████████▋ │

│ 12 │ ██████████████████████████ │ █████████████████████████████████████████████████ │ ██████████████████████████████████████████████████ │

│ 13 │ ███████████████████████▍ │ █████████████████ │ ██████████████████▎ │

│ 14 │ █████████████████████████▌ │ ███████████████ │ ████████████████████▏ │

│ 15 │ ████████████████████████████▊ │ █████████████████████████▎ │ █████████████████████████████████▌ │

│ 16 │ ████████████████████████▌ │ ███████████████▊ │ ███████████████████▋ │

│ 17 │ █████████████████▎ │ ████████▏ │ ████████████▋ │

│ 18 │ ███████████████▍ │ ██████▊ │ ██████████ │

│ 19 │ ████████████████████▋ │ ██████████████▋ │ ██████████████████████▏ │

│ 20 │ █████████████████▌ │ ██████▏ │ ███████▊ │

│ 21 │ ████████████████▌ │ ██████████████████████████████████████████████████ │ █████████████▊ │

│ 22 │ ██████████▋ │ ██████▋ │ █████████████▏ │

│ 23 │ ████████████▌ │ █████▌ │ █████▋ │

└───────────┴───────────────────────────────┴────────────────────────────────────────────────────┴────────────────────────────────────────────────────┘

24 rows in set. Elapsed: 0.038 sec. Processed 266.05 thousand rows, 14.66 MB (7.09 million rows/s., 390.69 MB/s.)

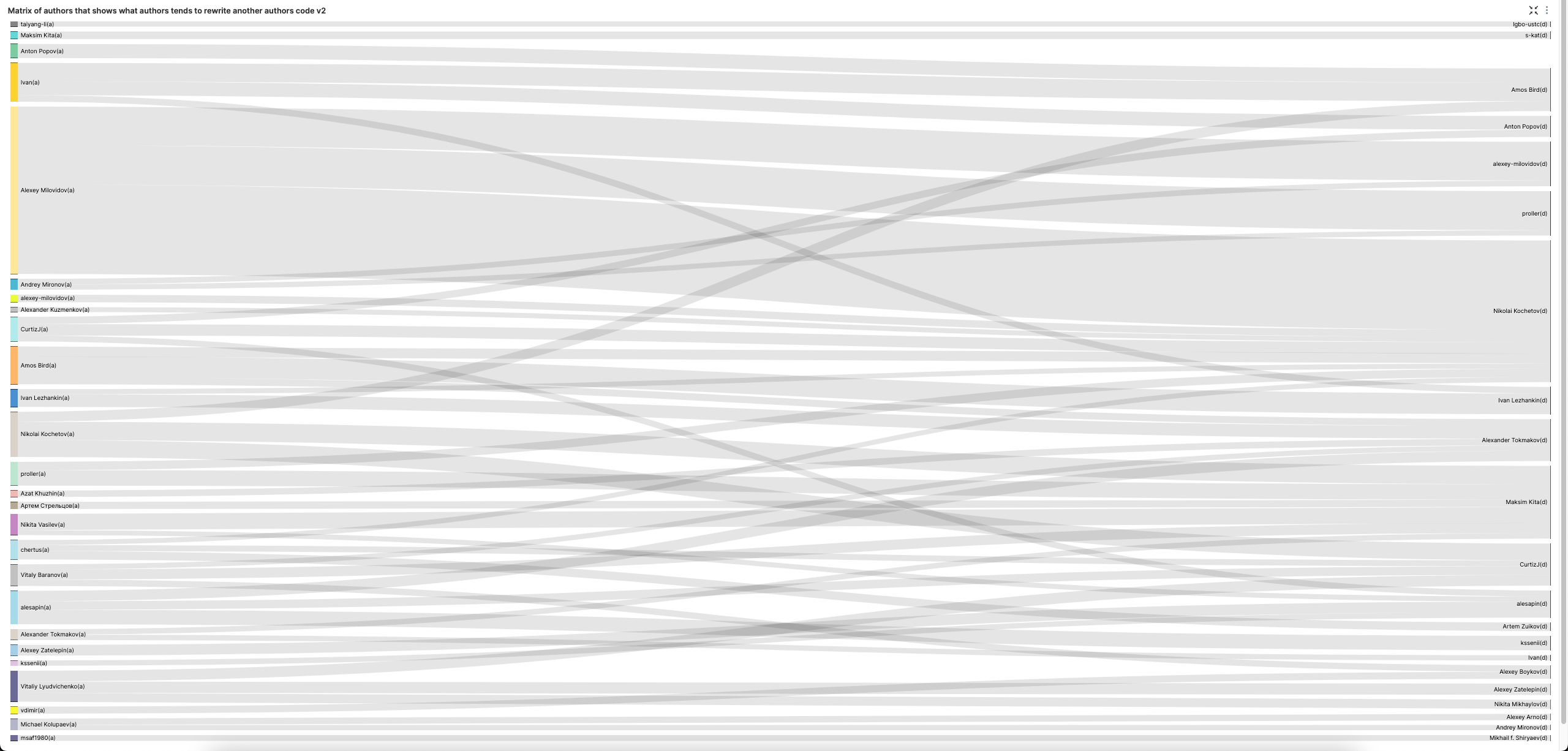

どの著者が他の著者のコードを書き換える傾向があるかを示す著者間マトリクス

sign = -1 はコードの削除を示します。句読点と空行の挿入は除外します。

SELECT

prev_author || '(a)' AS add_author,

author || '(d)' AS delete_author,

count() AS c

FROM git.line_changes

WHERE (sign = -1) AND (file_extension IN ('h', 'cpp')) AND (line_type NOT IN ('Punct', 'Empty')) AND (author != prev_author) AND (prev_author != '')

GROUP BY

prev_author,

author

ORDER BY c DESC

LIMIT 1 BY prev_author

LIMIT 100

┌─prev_author──────────┬─author───────────┬─────c─┐

│ Ivan │ Alexey Milovidov │ 18554 │

│ Alexey Arno │ Alexey Milovidov │ 18475 │

│ Michael Kolupaev │ Alexey Milovidov │ 14135 │

│ Alexey Milovidov │ Nikolai Kochetov │ 13435 │

│ Andrey Mironov │ Alexey Milovidov │ 10418 │

│ proller │ Alexey Milovidov │ 7280 │

│ Nikolai Kochetov │ Alexey Milovidov │ 6806 │

│ alexey-milovidov │ Alexey Milovidov │ 5027 │

│ Vitaliy Lyudvichenko │ Alexey Milovidov │ 4390 │

│ Amos Bird │ Ivan Lezhankin │ 3125 │

│ f1yegor │ Alexey Milovidov │ 3119 │

│ Pavel Kartavyy │ Alexey Milovidov │ 3087 │

│ Alexey Zatelepin │ Alexey Milovidov │ 2978 │

│ alesapin │ Alexey Milovidov │ 2949 │

│ Sergey Fedorov │ Alexey Milovidov │ 2727 │

│ Ivan Lezhankin │ Alexey Milovidov │ 2618 │

│ Vasily Nemkov │ Alexey Milovidov │ 2547 │

│ Alexander Tokmakov │ Alexey Milovidov │ 2493 │

│ Nikita Vasilev │ Maksim Kita │ 2420 │

│ Anton Popov │ Amos Bird │ 2127 │

└──────────────────────┴──────────────────┴───────┘

20 rows in set. Elapsed: 0.098 sec. Processed 7.54 million rows, 42.16 MB (76.67 million rows/s., 428.99 MB/s.)

Sankey チャート(SuperSet)を使うと、これをわかりやすく可視化できます。可視化のバリエーションを増やすため、LIMIT BY を 3 に増やし、各 author ごとにコード削除数の上位 3 名を取得しています。

Alexey は明らかに他人のコードを削除するのが好きなようです。コード削除の状況をよりバランスよく見るために、彼を除外してみましょう。

曜日ごとに貢献割合が最も高いのは誰か?

コミット数だけで見ると:

SELECT

day_of_week,

author,

count() AS c

FROM git.commits

GROUP BY

dayOfWeek(time) AS day_of_week,

author

ORDER BY

day_of_week ASC,

c DESC

LIMIT 1 BY day_of_week

┌─day_of_week─┬─author───────────┬────c─┐

│ 1 │ Alexey Milovidov │ 2204 │

│ 2 │ Alexey Milovidov │ 1588 │

│ 3 │ Alexey Milovidov │ 1725 │

│ 4 │ Alexey Milovidov │ 1915 │

│ 5 │ Alexey Milovidov │ 1940 │

│ 6 │ Alexey Milovidov │ 1851 │

│ 7 │ Alexey Milovidov │ 2400 │

└─────────────┴──────────────────┴──────┘

7 rows in set. Elapsed: 0.012 sec. Processed 62.78 thousand rows, 395.47 KB (5.44 million rows/s., 34.27 MB/s.)

では、ここでは最も長く貢献しているコントリビューターである我々の創業者 Alexey に有利に働きそうです。分析対象を直近 1 年間に絞り込みましょう。

SELECT

day_of_week,

author,

count() AS c

FROM git.commits

WHERE time > (now() - toIntervalYear(1))

GROUP BY

dayOfWeek(time) AS day_of_week,

author

ORDER BY

day_of_week ASC,

c DESC

LIMIT 1 BY day_of_week

┌─day_of_week─┬─author───────────┬───c─┐

│ 1 │ Alexey Milovidov │ 198 │

│ 2 │ alesapin │ 162 │

│ 3 │ alesapin │ 163 │

│ 4 │ Azat Khuzhin │ 166 │

│ 5 │ alesapin │ 191 │

│ 6 │ Alexey Milovidov │ 179 │

│ 7 │ Alexey Milovidov │ 243 │

└─────────────┴──────────────────┴─────┘

7 rows in set. Elapsed: 0.004 sec. Processed 21.82 thousand rows, 140.02 KB (4.88 million rows/s., 31.29 MB/s.)

これはまだ少し単純で、人々の仕事量を十分に反映していません。

より適した指標としては、過去 1 年間に実行された総作業量に対する割合として、各日ごとのトップコントリビューターを算出する方法が考えられます。ここでは、コードの削除と追加を同じ重みで扱う点に注意してください。

SELECT

top_author.day_of_week,

top_author.author,

top_author.author_work / all_work.total_work AS top_author_percent

FROM

(

SELECT

day_of_week,

author,

sum(lines_added) + sum(lines_deleted) AS author_work

FROM git.file_changes

WHERE time > (now() - toIntervalYear(1))

GROUP BY

author,

dayOfWeek(time) AS day_of_week

ORDER BY

day_of_week ASC,

author_work DESC

LIMIT 1 BY day_of_week

) AS top_author

INNER JOIN

(

SELECT

day_of_week,

sum(lines_added) + sum(lines_deleted) AS total_work

FROM git.file_changes

WHERE time > (now() - toIntervalYear(1))

GROUP BY dayOfWeek(time) AS day_of_week

) AS all_work USING (day_of_week)

┌─day_of_week─┬─author──────────────┬──top_author_percent─┐

│ 1 │ Alexey Milovidov │ 0.3168282877768332 │

│ 2 │ Mikhail f. Shiryaev │ 0.3523434231193969 │

│ 3 │ vdimir │ 0.11859742484577324 │

│ 4 │ Nikolay Degterinsky │ 0.34577318920318467 │

│ 5 │ Alexey Milovidov │ 0.13208704423684223 │

│ 6 │ Alexey Milovidov │ 0.18895257783624633 │

│ 7 │ Robert Schulze │ 0.3617405888930302 │

└─────────────┴─────────────────────┴─────────────────────┘

7 rows in set. Elapsed: 0.014 sec. Processed 106.12 thousand rows, 1.38 MB (7.61 million rows/s., 98.65 MB/s.)

リポジトリ全体におけるコードの年代分布

解析対象は現存するファイルのみに限定します。結果を簡潔に示すため、ルートフォルダーごとに階層の深さを 2、各ルートフォルダーあたり 5 ファイルまでに制限しています。必要に応じて調整してください。

WITH current_files AS

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND (NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)'))

ORDER BY path ASC

)

SELECT

concat(root, '/', sub_folder) AS folder,

round(avg(days_present)) AS avg_age_of_files,

min(days_present) AS min_age_files,

max(days_present) AS max_age_files,

count() AS c

FROM

(

SELECT

path,

dateDiff('day', min(time), toDate('2022-11-03')) AS days_present

FROM git.file_changes

WHERE (path IN (current_files)) AND (file_extension IN ('h', 'cpp', 'sql'))

GROUP BY path

)

GROUP BY

splitByChar('/', path)[1] AS root,

splitByChar('/', path)[2] AS sub_folder

ORDER BY

root ASC,

c DESC

LIMIT 5 BY root

┌─folder───────────────────────────┬─avg_age_of_files─┬─min_age_files─┬─max_age_files─┬────c─┐

│ base/base │ 387 │ 201 │ 397 │ 84 │

│ base/glibc-compatibility │ 887 │ 59 │ 993 │ 19 │

│ base/consistent-hashing │ 993 │ 993 │ 993 │ 5 │

│ base/widechar_width │ 993 │ 993 │ 993 │ 2 │

│ base/consistent-hashing-sumbur │ 993 │ 993 │ 993 │ 2 │

│ docker/test │ 1043 │ 1043 │ 1043 │ 1 │

│ programs/odbc-bridge │ 835 │ 91 │ 945 │ 25 │

│ programs/copier │ 587 │ 14 │ 945 │ 22 │

│ programs/library-bridge │ 155 │ 47 │ 608 │ 21 │

│ programs/disks │ 144 │ 62 │ 150 │ 14 │

│ programs/server │ 874 │ 709 │ 945 │ 10 │

│ rust/BLAKE3 │ 52 │ 52 │ 52 │ 1 │

│ src/Functions │ 752 │ 0 │ 944 │ 809 │

│ src/Storages │ 700 │ 8 │ 944 │ 736 │

│ src/Interpreters │ 684 │ 3 │ 944 │ 490 │

│ src/Processors │ 703 │ 44 │ 944 │ 482 │

│ src/Common │ 673 │ 7 │ 944 │ 473 │

│ tests/queries │ 674 │ -5 │ 945 │ 3777 │

│ tests/integration │ 656 │ 132 │ 945 │ 4 │

│ utils/memcpy-bench │ 601 │ 599 │ 605 │ 10 │

│ utils/keeper-bench │ 570 │ 569 │ 570 │ 7 │

│ utils/durability-test │ 793 │ 793 │ 793 │ 4 │

│ utils/self-extracting-executable │ 143 │ 143 │ 143 │ 3 │

│ utils/self-extr-exec │ 224 │ 224 │ 224 │ 2 │

└──────────────────────────────────┴──────────────────┴───────────────┴───────────────┴──────┘

24 rows in set. Elapsed: 0.129 sec. Processed 798.15 thousand rows, 15.11 MB (6.19 million rows/s., 117.08 MB/s.)

ある著者のコードのうち、他の著者によって削除された割合はどれくらいか?

この問いでは、ある著者が記述した行数を、その著者のコードから他のコントリビューターによって削除された行数の合計で割った値が必要です。

SELECT

k,

written_code.c,

removed_code.c,

removed_code.c / written_code.c AS remove_ratio

FROM

(

SELECT

author AS k,

count() AS c

FROM git.line_changes

WHERE (sign = 1) AND (file_extension IN ('h', 'cpp')) AND (line_type NOT IN ('Punct', 'Empty'))

GROUP BY k

) AS written_code

INNER JOIN

(

SELECT

prev_author AS k,

count() AS c

FROM git.line_changes

WHERE (sign = -1) AND (file_extension IN ('h', 'cpp')) AND (line_type NOT IN ('Punct', 'Empty')) AND (author != prev_author)

GROUP BY k

) AS removed_code USING (k)

WHERE written_code.c > 1000

ORDER BY remove_ratio DESC

LIMIT 10

┌─k──────────────────┬─────c─┬─removed_code.c─┬───────remove_ratio─┐

│ Marek Vavruša │ 1458 │ 1318 │ 0.9039780521262003 │

│ Ivan │ 32715 │ 27500 │ 0.8405930001528351 │

│ artpaul │ 3450 │ 2840 │ 0.8231884057971014 │

│ Silviu Caragea │ 1542 │ 1209 │ 0.7840466926070039 │

│ Ruslan │ 1027 │ 802 │ 0.7809152872444012 │

│ Tsarkova Anastasia │ 1755 │ 1364 │ 0.7772079772079772 │

│ Vyacheslav Alipov │ 3526 │ 2727 │ 0.7733976176971072 │

│ Marek Vavruša │ 1467 │ 1124 │ 0.7661895023858214 │

│ f1yegor │ 7194 │ 5213 │ 0.7246316374756742 │

│ kreuzerkrieg │ 3406 │ 2468 │ 0.724603640634175 │

└────────────────────┴───────┴────────────────┴────────────────────┘

10 rows in set. Elapsed: 0.126 sec. Processed 15.07 million rows, 73.51 MB (119.97 million rows/s., 585.16 MB/s.)

最も多く書き換えが行われたファイルを一覧表示するには?

この問いに対する最も単純なアプローチは、(現在存在するファイルに限定して)パスごとに行の変更回数を単純にカウントすることです。例えば:

WITH current_files AS

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND (NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)'))

ORDER BY path ASC

)

SELECT

path,

count() AS c

FROM git.line_changes

WHERE (file_extension IN ('h', 'cpp', 'sql')) AND (path IN (current_files))

GROUP BY path

ORDER BY c DESC

LIMIT 10

┌─path───────────────────────────────────────────────────┬─────c─┐

│ src/Storages/StorageReplicatedMergeTree.cpp │ 21871 │

│ src/Storages/MergeTree/MergeTreeData.cpp │ 17709 │

│ programs/client/Client.cpp │ 15882 │

│ src/Storages/MergeTree/MergeTreeDataSelectExecutor.cpp │ 14249 │

│ src/Interpreters/InterpreterSelectQuery.cpp │ 12636 │

│ src/Parsers/ExpressionListParsers.cpp │ 11794 │

│ src/Analyzer/QueryAnalysisPass.cpp │ 11760 │

│ src/Coordination/KeeperStorage.cpp │ 10225 │

│ src/Functions/FunctionsConversion.h │ 9247 │

│ src/Parsers/ExpressionElementParsers.cpp │ 8197 │

└────────────────────────────────────────────────────────┴───────┘

10 rows in set. Elapsed: 0.160 sec. Processed 8.07 million rows, 98.99 MB (50.49 million rows/s., 619.49 MB/s.)

ただし、これは、任意のコミットでファイルの大部分が変更される「リライト」という概念は捉えられていません。これには、より複雑なクエリが必要です。ここでは、ファイル行数の 50% 超が削除され、かつ 50% 超が追加される場合をリライトとみなします。何をリライトと見なすかは、その定義に合わせてクエリを調整してください。

このクエリは現在存在するファイルのみに限定されています。path と commit_hash でグルーピングしてすべてのファイル変更を列挙し、追加および削除された行数を返します。ウィンドウ関数を使用して、変更がファイルサイズに与える影響を lines added - lines removed として見積もり、その累積和を計算することで、任意の時点でのファイルの総サイズを推定します。この統計量を使って、各変更ごとにファイルのうち何パーセントが追加または削除されたかを算出できます。最後に、ファイルごとにリライトと見なせる変更の回数、すなわち (percent_add >= 0.5) AND (percent_delete >= 0.5) AND current_size > 50 を満たす変更の数を数えます。ファイルの初期の貢献がリライトとしてカウントされるのを避けるため、50 行を超えるファイルのみを対象としています。これはまた、リライトされやすい非常に小さいファイルへのバイアスも避けられます。

WITH

current_files AS

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND (NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)'))

ORDER BY path ASC

),

changes AS

(

SELECT

path,

max(time) AS max_time,

commit_hash,

any(lines_added) AS num_added,

any(lines_deleted) AS num_deleted,

any(change_type) AS type

FROM git.file_changes

WHERE (change_type IN ('Add', 'Modify')) AND (path IN (current_files)) AND (file_extension IN ('h', 'cpp', 'sql'))

GROUP BY

path,

commit_hash

ORDER BY

path ASC,

max_time ASC

),

rewrites AS

(

SELECT

path,

commit_hash,

max_time,

type,

num_added,

num_deleted,

sum(num_added - num_deleted) OVER (PARTITION BY path ORDER BY max_time ASC) AS current_size,

if(current_size > 0, num_added / current_size, 0) AS percent_add,

if(current_size > 0, num_deleted / current_size, 0) AS percent_delete

FROM changes

)

SELECT

path,

count() AS num_rewrites

FROM rewrites

WHERE (type = 'Modify') AND (percent_add >= 0.5) AND (percent_delete >= 0.5) AND (current_size > 50)

GROUP BY path

ORDER BY num_rewrites DESC

LIMIT 10

┌─path──────────────────────────────────────────────────┬─num_rewrites─┐

│ src/Storages/WindowView/StorageWindowView.cpp │ 8 │

│ src/Functions/array/arrayIndex.h │ 7 │

│ src/Dictionaries/CacheDictionary.cpp │ 6 │

│ src/Dictionaries/RangeHashedDictionary.cpp │ 5 │

│ programs/client/Client.cpp │ 4 │

│ src/Functions/polygonPerimeter.cpp │ 4 │

│ src/Functions/polygonsEquals.cpp │ 4 │

│ src/Functions/polygonsWithin.cpp │ 4 │

│ src/Processors/Formats/Impl/ArrowColumnToCHColumn.cpp │ 4 │

│ src/Functions/polygonsSymDifference.cpp │ 4 │

└───────────────────────────────────────────────────────┴──────────────┘

10 rows in set. Elapsed: 0.299 sec. Processed 798.15 thousand rows, 31.52 MB (2.67 million rows/s., 105.29 MB/s.)

どの曜日に追加されたコードが、リポジトリ内に最も長く残りやすいでしょうか?

このためには、コードの行を一意に特定する必要があります。同じ行がファイル内に複数回現れる可能性があるため、パスと行の内容を使って推定します。

まず追加された行をクエリし、それを削除された行と結合します。そのうえで、削除のほうが追加よりも後に起きているケースに絞り込みます。これにより削除された行を特定でき、その2つのイベント間の経過時間を計算できます。

最後に、このデータセット全体を集計し、曜日ごとに行がリポジトリ内にとどまる平均日数を算出します。

SELECT

day_of_week_added,

count() AS num,

avg(days_present) AS avg_days_present

FROM

(

SELECT

added_code.line,

added_code.time AS added_day,

dateDiff('day', added_code.time, removed_code.time) AS days_present

FROM

(

SELECT

path,

line,

max(time) AS time

FROM git.line_changes

WHERE (sign = 1) AND (line_type NOT IN ('Punct', 'Empty'))

GROUP BY

path,

line

) AS added_code

INNER JOIN

(

SELECT

path,

line,

max(time) AS time

FROM git.line_changes

WHERE (sign = -1) AND (line_type NOT IN ('Punct', 'Empty'))

GROUP BY

path,

line

) AS removed_code USING (path, line)

WHERE removed_code.time > added_code.time

)

GROUP BY dayOfWeek(added_day) AS day_of_week_added

┌─day_of_week_added─┬────num─┬───avg_days_present─┐

│ 1 │ 171879 │ 193.81759260875384 │

│ 2 │ 141448 │ 153.0931013517335 │

│ 3 │ 161230 │ 137.61553681076722 │

│ 4 │ 255728 │ 121.14149799787273 │

│ 5 │ 203907 │ 141.60181847606998 │

│ 6 │ 62305 │ 202.43449161383518 │

│ 7 │ 70904 │ 220.0266134491707 │

└───────────────────┴────────┴────────────────────┘

7 rows in set. Elapsed: 3.965 sec. Processed 15.07 million rows, 1.92 GB (3.80 million rows/s., 483.50 MB/s.)

ファイルを平均コード年齢順にソート

このクエリは、どの曜日に追加されたコードがリポジトリに残りやすいか と同じ原理を使用し、パスと行の内容によってコード行を一意に識別することを目的としています。 これにより、ある行が追加されてから削除されるまでの期間を特定できます。ただしここでは、現在存在するファイルかつ現在のコードのみを対象とし、各ファイルについて行ごとの期間を平均します。

WITH

current_files AS

(

SELECT path

FROM

(

SELECT

old_path AS path,

max(time) AS last_time,

2 AS change_type

FROM git.file_changes

GROUP BY old_path

UNION ALL

SELECT

path,

max(time) AS last_time,

argMax(change_type, time) AS change_type

FROM git.clickhouse_file_changes

GROUP BY path

)

GROUP BY path

HAVING (argMax(change_type, last_time) != 2) AND (NOT match(path, '(^dbms/)|(^libs/)|(^tests/testflows/)|(^programs/server/store/)'))

ORDER BY path ASC

),

lines_removed AS

(

SELECT

added_code.path AS path,

added_code.line,

added_code.time AS added_day,

dateDiff('day', added_code.time, removed_code.time) AS days_present

FROM

(

SELECT

path,

line,

max(time) AS time,

any(file_extension) AS file_extension

FROM git.line_changes

WHERE (sign = 1) AND (line_type NOT IN ('Punct', 'Empty'))

GROUP BY

path,

line

) AS added_code

INNER JOIN

(

SELECT

path,

line,

max(time) AS time

FROM git.line_changes

WHERE (sign = -1) AND (line_type NOT IN ('Punct', 'Empty'))

GROUP BY

path,

line

) AS removed_code USING (path, line)

WHERE (removed_code.time > added_code.time) AND (path IN (current_files)) AND (file_extension IN ('h', 'cpp', 'sql'))

)

SELECT

path,

avg(days_present) AS avg_code_age

FROM lines_removed

GROUP BY path

ORDER BY avg_code_age DESC

LIMIT 10

┌─path────────────────────────────────────────────────────────────┬──────avg_code_age─┐

│ utils/corrector_utf8/corrector_utf8.cpp │ 1353.888888888889 │

│ tests/queries/0_stateless/01288_shard_max_network_bandwidth.sql │ 881 │

│ src/Functions/replaceRegexpOne.cpp │ 861 │

│ src/Functions/replaceRegexpAll.cpp │ 861 │

│ src/Functions/replaceOne.cpp │ 861 │

│ utils/zookeeper-remove-by-list/main.cpp │ 838.25 │

│ tests/queries/0_stateless/01356_state_resample.sql │ 819 │

│ tests/queries/0_stateless/01293_create_role.sql │ 819 │

│ src/Functions/ReplaceStringImpl.h │ 810 │

│ src/Interpreters/createBlockSelector.cpp │ 795 │

└─────────────────────────────────────────────────────────────────┴───────────────────┘

10 rows in set. Elapsed: 3.134 sec. Processed 16.13 million rows, 1.83 GB (5.15 million rows/s., 582.99 MB/s.)

誰がより多くのテスト / CPP コード / コメントを書く傾向があるのか?

この問いにはいくつかのアプローチがあります。コードとテストの比率に着目すると、このクエリは比較的単純です。tests を含むディレクトリへのコントリビューション数を数え、それを全体のコントリビューション数に対する比率として計算します。

ここでは、一度きりのコントリビューションによる偏りを避けて継続的なコミッターに注目するため、変更回数が 20 回を超えるユーザーのみにクエリを絞っています。

SELECT

author,

countIf((file_extension IN ('h', 'cpp', 'sql', 'sh', 'py', 'expect')) AND (path LIKE '%tests%')) AS test,

countIf((file_extension IN ('h', 'cpp', 'sql')) AND (NOT (path LIKE '%tests%'))) AS code,

code / (code + test) AS ratio_code

FROM git.clickhouse_file_changes

GROUP BY author

HAVING code > 20

ORDER BY code DESC

LIMIT 20

┌─author───────────────┬─test─┬──code─┬─────────ratio_code─┐

│ Alexey Milovidov │ 6617 │ 41799 │ 0.8633303040317251 │

│ Nikolai Kochetov │ 916 │ 13361 │ 0.9358408629263851 │

│ alesapin │ 2408 │ 8796 │ 0.785076758300607 │

│ kssenii │ 869 │ 6769 │ 0.8862267609321812 │

│ Maksim Kita │ 799 │ 5862 │ 0.8800480408347096 │

│ Alexander Tokmakov │ 1472 │ 5727 │ 0.7955271565495208 │

│ Vitaly Baranov │ 1764 │ 5521 │ 0.7578586135895676 │

│ Ivan Lezhankin │ 843 │ 4698 │ 0.8478613968597726 │

│ Anton Popov │ 599 │ 4346 │ 0.8788675429726996 │

│ Ivan │ 2630 │ 4269 │ 0.6187853312074214 │

│ Azat Khuzhin │ 1664 │ 3697 │ 0.689610147360567 │

│ Amos Bird │ 400 │ 2901 │ 0.8788245986064829 │

│ proller │ 1207 │ 2377 │ 0.6632254464285714 │

│ chertus │ 453 │ 2359 │ 0.8389046941678521 │

│ alexey-milovidov │ 303 │ 2321 │ 0.8845274390243902 │

│ Alexey Arno │ 169 │ 2310 │ 0.9318273497377975 │

│ Vitaliy Lyudvichenko │ 334 │ 2283 │ 0.8723729461215132 │

│ Robert Schulze │ 182 │ 2196 │ 0.9234650967199327 │

│ CurtizJ │ 460 │ 2158 │ 0.8242933537051184 │

│ Alexander Kuzmenkov │ 298 │ 2092 │ 0.8753138075313808 │

└──────────────────────┴──────┴───────┴────────────────────┘

20 rows in set. Elapsed: 0.034 sec. Processed 266.05 thousand rows, 4.65 MB (7.93 million rows/s., 138.76 MB/s.)

この分布はヒストグラムとして可視化できます。

WITH (

SELECT histogram(10)(ratio_code) AS hist

FROM

(

SELECT

author,

countIf((file_extension IN ('h', 'cpp', 'sql', 'sh', 'py', 'expect')) AND (path LIKE '%tests%')) AS test,

countIf((file_extension IN ('h', 'cpp', 'sql')) AND (NOT (path LIKE '%tests%'))) AS code,

code / (code + test) AS ratio_code

FROM git.clickhouse_file_changes

GROUP BY author

HAVING code > 20

ORDER BY code DESC

LIMIT 20

)

) AS hist

SELECT

arrayJoin(hist).1 AS lower,

arrayJoin(hist).2 AS upper,

bar(arrayJoin(hist).3, 0, 100, 500) AS bar

┌──────────────lower─┬──────────────upper─┬─bar───────────────────────────┐

│ 0.6187853312074214 │ 0.6410053888179964 │ █████ │

│ 0.6410053888179964 │ 0.6764177968945693 │ █████ │

│ 0.6764177968945693 │ 0.7237343804750673 │ █████ │

│ 0.7237343804750673 │ 0.7740802855073157 │ █████▋ │

│ 0.7740802855073157 │ 0.807297655565091 │ ████████▋ │

│ 0.807297655565091 │ 0.8338381996094653 │ ██████▎ │

│ 0.8338381996094653 │ 0.8533566747727687 │ ████████▋ │

│ 0.8533566747727687 │ 0.871392376017531 │ █████████▍ │

│ 0.871392376017531 │ 0.904916108899021 │ ████████████████████████████▋ │

│ 0.904916108899021 │ 0.9358408629263851 │ █████████████████▌ │

└────────────────────┴────────────────────┴───────────────────────────────┘

10 rows in set. Elapsed: 0.051 sec. Processed 266.05 thousand rows, 4.65 MB (5.24 million rows/s., 91.64 MB/s.)

ほとんどのコントリビューターは、予想どおりテストよりも多くのコードを書いています。

では、コードをコントリビュートするときに最も多くコメントを追加しているのは誰でしょうか?

SELECT

author,

avg(ratio_comments) AS avg_ratio_comments,

sum(code) AS code

FROM

(

SELECT

author,

commit_hash,

countIf(line_type = 'Comment') AS comments,

countIf(line_type = 'Code') AS code,

if(comments > 0, comments / (comments + code), 0) AS ratio_comments

FROM git.clickhouse_line_changes

GROUP BY

author,

commit_hash

)

GROUP BY author

ORDER BY code DESC

LIMIT 10

┌─author─────────────┬──avg_ratio_comments─┬────code─┐

│ Alexey Milovidov │ 0.1034915408309902 │ 1147196 │

│ s-kat │ 0.1361718900215362 │ 614224 │

│ Nikolai Kochetov │ 0.08722993407690126 │ 218328 │

│ alesapin │ 0.1040477684726504 │ 198082 │

│ Vitaly Baranov │ 0.06446875712939285 │ 161801 │

│ Maksim Kita │ 0.06863376297549255 │ 156381 │

│ Alexey Arno │ 0.11252677608033655 │ 146642 │

│ Vitaliy Zakaznikov │ 0.06199215397180561 │ 138530 │

│ kssenii │ 0.07455322590796751 │ 131143 │

│ Artur │ 0.12383737231074826 │ 121484 │

└────────────────────┴─────────────────────┴─────────┘

10 rows in set. Elapsed: 0.290 sec. Processed 7.54 million rows, 394.57 MB (26.00 million rows/s., 1.36 GB/s.)

ここではコードへの貢献量でソートしている点に注意してください。主要なコントリビューターはいずれもコード(コメントではなく)の割合が驚くほど高く、そのことがコードの可読性の高さの一因になっています。

コード/コメントの割合という観点で、ある開発者のコミットは時間とともにどのように変化するか?

開発者ごとにこれを算出するのは容易です。

SELECT

author,

countIf(line_type = 'Code') AS code_lines,

countIf((line_type = 'Comment') OR (line_type = 'Punct')) AS comments,

code_lines / (comments + code_lines) AS ratio_code,

toStartOfWeek(time) AS week

FROM git.line_changes

GROUP BY

time,

author

ORDER BY

author ASC,

time ASC

LIMIT 10

┌─author──────────────────────┬─code_lines─┬─comments─┬─────────ratio_code─┬───────week─┐

│ 1lann │ 8 │ 0 │ 1 │ 2022-03-06 │

│ 20018712 │ 2 │ 0 │ 1 │ 2020-09-13 │

│ 243f6a8885a308d313198a2e037 │ 0 │ 2 │ 0 │ 2020-12-06 │

│ 243f6a8885a308d313198a2e037 │ 0 │ 112 │ 0 │ 2020-12-06 │

│ 243f6a8885a308d313198a2e037 │ 0 │ 14 │ 0 │ 2020-12-06 │

│ 3ldar-nasyrov │ 2 │ 0 │ 1 │ 2021-03-14 │

│ [email protected] │ 27 │ 2 │ 0.9310344827586207 │ 2019-04-21 │

│ ANDREI STAROVEROV │ 182 │ 60 │ 0.7520661157024794 │ 2021-05-09 │

│ ANDREI STAROVEROV │ 7 │ 0 │ 1 │ 2021-05-09 │

│ ANDREI STAROVEROV │ 32 │ 12 │ 0.7272727272727273 │ 2021-05-09 │

└─────────────────────────────┴────────────┴──────────┴────────────────────┴────────────┘

10 rows in set. Elapsed: 0.145 sec. Processed 7.54 million rows, 51.09 MB (51.83 million rows/s., 351.44 MB/s.)

しかし理想的には、すべての著者について、最初にコミットをし始めた日からの期間を集計して、これがどのように変化していくかを見たいところです。時間の経過とともに、コメントを書く割合はゆっくりと減っていくのでしょうか?

これを計算するために、まず各著者のコメント比率を時間経過とともに算出します。これは Who tends to write more tests / CPP code / comments? と同様です。次にこれを各著者の開始日にひも付け、開始からの週オフセットごとのコメント比率を算出できるようにします。

すべての著者に対して週オフセットごとの平均を計算したあと、その結果を 10 週ごとに抽出してサンプリングします。

WITH author_ratios_by_offset AS

(

SELECT

author,

dateDiff('week', start_dates.start_date, contributions.week) AS week_offset,

ratio_code

FROM

(

SELECT

author,

toStartOfWeek(min(time)) AS start_date

FROM git.line_changes

WHERE file_extension IN ('h', 'cpp', 'sql')

GROUP BY author AS start_dates

) AS start_dates

INNER JOIN

(

SELECT

author,

countIf(line_type = 'Code') AS code,

countIf((line_type = 'Comment') OR (line_type = 'Punct')) AS comments,

comments / (comments + code) AS ratio_code,

toStartOfWeek(time) AS week

FROM git.line_changes

WHERE (file_extension IN ('h', 'cpp', 'sql')) AND (sign = 1)

GROUP BY

time,

author

HAVING code > 20

ORDER BY

author ASC,

time ASC

) AS contributions USING (author)

)

SELECT

week_offset,

avg(ratio_code) AS avg_code_ratio

FROM author_ratios_by_offset

GROUP BY week_offset

HAVING (week_offset % 10) = 0

ORDER BY week_offset ASC

LIMIT 20

┌─week_offset─┬──────avg_code_ratio─┐

│ 0 │ 0.21626798253005078 │

│ 10 │ 0.18299433892099454 │

│ 20 │ 0.22847255749045017 │

│ 30 │ 0.2037816688365288 │

│ 40 │ 0.1987063517030308 │

│ 50 │ 0.17341406302829748 │

│ 60 │ 0.1808884776496144 │

│ 70 │ 0.18711773536450496 │

│ 80 │ 0.18905573684766458 │

│ 90 │ 0.2505147771581594 │

│ 100 │ 0.2427673990917429 │

│ 110 │ 0.19088569009169926 │

│ 120 │ 0.14218574654598348 │

│ 130 │ 0.20894252550489317 │

│ 140 │ 0.22316626978848397 │

│ 150 │ 0.1859507592277053 │

│ 160 │ 0.22007759757363546 │

│ 170 │ 0.20406936638195144 │

│ 180 │ 0.1412102467834332 │

│ 190 │ 0.20677550885049117 │

└─────────────┴─────────────────────┘

20 rows in set. Elapsed: 0.167 sec. Processed 15.07 million rows, 101.74 MB (90.51 million rows/s., 610.98 MB/s.)

心強いことに、コメント率はほぼ一定のままで、著者が長く貢献し続けても低下していません。

コードが書き換えられるまでの平均時間と中央値(コード劣化の半減期)はどれくらいですか?

すべてのファイルを対象に書き換えを特定するために、最も多くの回数書き換えられたファイル、または最も多くの著者によって編集されたファイルを一覧表示する 場合と同じ原理を用いることができます。各ファイルについて、書き換えと書き換えの間の時間を計算するためにウィンドウ関数を使用します。これにより、すべてのファイルを対象に平均と中央値を算出できます。

WITH

changes AS

(

SELECT

path,

commit_hash,

max_time,

type,

num_added,

num_deleted,

sum(num_added - num_deleted) OVER (PARTITION BY path ORDER BY max_time ASC) AS current_size,

if(current_size > 0, num_added / current_size, 0) AS percent_add,

if(current_size > 0, num_deleted / current_size, 0) AS percent_delete

FROM

(

SELECT

path,

max(time) AS max_time,

commit_hash,

any(lines_added) AS num_added,

any(lines_deleted) AS num_deleted,

any(change_type) AS type

FROM git.file_changes

WHERE (change_type IN ('Add', 'Modify')) AND (file_extension IN ('h', 'cpp', 'sql'))

GROUP BY

path,

commit_hash

ORDER BY

path ASC,

max_time ASC

)

),

rewrites AS

(

SELECT

*,

any(max_time) OVER (PARTITION BY path ORDER BY max_time ASC ROWS BETWEEN 1 PRECEDING AND CURRENT ROW) AS previous_rewrite,

dateDiff('day', previous_rewrite, max_time) AS rewrite_days

FROM changes

WHERE (type = 'Modify') AND (percent_add >= 0.5) AND (percent_delete >= 0.5) AND (current_size > 50)

)

SELECT

avgIf(rewrite_days, rewrite_days > 0) AS avg_rewrite_time,

quantilesTimingIf(0.5)(rewrite_days, rewrite_days > 0) AS half_life

FROM rewrites

┌─avg_rewrite_time─┬─half_life─┐

│ 122.2890625 │ [23] │

└──────────────────┴───────────┘

1 row in set. Elapsed: 0.388 sec. Processed 266.05 thousand rows, 22.85 MB (685.82 thousand rows/s., 58.89 MB/s.)

コードが書き直される可能性が最も高いという意味で、いつコードを書くのが最悪でしょうか?

コードが書き直されるまでの平均時間と中央値(コード劣化の半減期)はどれくらいか? および 最も多くの回数、または最も多くの著者によって書き直されたファイルを一覧表示 と似ていますが、ここでは曜日ごとに集計します。必要に応じて、たとえば年の月ごとなどに調整してください。

WITH

changes AS

(

SELECT

path,

commit_hash,

max_time,

type,

num_added,

num_deleted,

sum(num_added - num_deleted) OVER (PARTITION BY path ORDER BY max_time ASC) AS current_size,

if(current_size > 0, num_added / current_size, 0) AS percent_add,

if(current_size > 0, num_deleted / current_size, 0) AS percent_delete

FROM

(

SELECT

path,

max(time) AS max_time,

commit_hash,

any(file_lines_added) AS num_added,

any(file_lines_deleted) AS num_deleted,

any(file_change_type) AS type

FROM git.line_changes

WHERE (file_change_type IN ('Add', 'Modify')) AND (file_extension IN ('h', 'cpp', 'sql'))

GROUP BY

path,

commit_hash

ORDER BY

path ASC,

max_time ASC

)

),

rewrites AS

(

SELECT any(max_time) OVER (PARTITION BY path ORDER BY max_time ASC ROWS BETWEEN 1 PRECEDING AND CURRENT ROW) AS previous_rewrite

FROM changes

WHERE (type = 'Modify') AND (percent_add >= 0.5) AND (percent_delete >= 0.5) AND (current_size > 50)

)

SELECT

dayOfWeek(previous_rewrite) AS dayOfWeek,

count() AS num_re_writes

FROM rewrites

GROUP BY dayOfWeek

┌─dayOfWeek─┬─num_re_writes─┐

│ 1 │ 111 │

│ 2 │ 121 │

│ 3 │ 91 │

│ 4 │ 111 │

│ 5 │ 90 │

│ 6 │ 64 │

│ 7 │ 46 │

└───────────┴───────────────┘

7 rows in set. Elapsed: 0.466 sec. Processed 7.54 million rows, 701.52 MB (16.15 million rows/s., 1.50 GB/s.)

どの著者のコードが最も「スティッキー」か?

ここでは、著者のコードが書き換えられるまでどれくらい長く残るかを「スティッキーさ」と定義します。前の質問 What is the average time before code will be rewritten and the median (half-life of code decay)? と同様に、ファイルに対する 50% の追加と 50% の削除という同じ基準で書き換えを定義します。著者ごとに平均の書き換えまでの時間を算出し、2 ファイルを超えるコントリビューターのみを対象とします。

WITH

changes AS

(

SELECT

path,

author,

commit_hash,

max_time,

type,

num_added,

num_deleted,

sum(num_added - num_deleted) OVER (PARTITION BY path ORDER BY max_time ASC) AS current_size,

if(current_size > 0, num_added / current_size, 0) AS percent_add,

if(current_size > 0, num_deleted / current_size, 0) AS percent_delete

FROM

(

SELECT

path,

any(author) AS author,

max(time) AS max_time,

commit_hash,

any(file_lines_added) AS num_added,

any(file_lines_deleted) AS num_deleted,

any(file_change_type) AS type

FROM git.line_changes

WHERE (file_change_type IN ('Add', 'Modify')) AND (file_extension IN ('h', 'cpp', 'sql'))

GROUP BY

path,

commit_hash

ORDER BY

path ASC,

max_time ASC

)

),

rewrites AS

(

SELECT

*,

any(max_time) OVER (PARTITION BY path ORDER BY max_time ASC ROWS BETWEEN 1 PRECEDING AND CURRENT ROW) AS previous_rewrite,

dateDiff('day', previous_rewrite, max_time) AS rewrite_days,

any(author) OVER (PARTITION BY path ORDER BY max_time ASC ROWS BETWEEN 1 PRECEDING AND CURRENT ROW) AS prev_author

FROM changes

WHERE (type = 'Modify') AND (percent_add >= 0.5) AND (percent_delete >= 0.5) AND (current_size > 50)

)